Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime-rl теперь имеет обширную поддержку для MoE как для RL, так и для SFT, мы обучали модель с более чем 100B параметрами с её помощью

У нас есть поддержка для:

* Qwen3 a3-30b

* серии GLM и Moonlight

* добавления серии gpt oss прямо сейчас

в итоге нам пришлось переписать большую часть кода моделирования, чтобы он работал с torch compile, оставаясь при этом совместимым с экосистемой hugging face

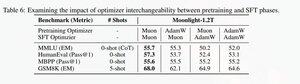

Мы также добавили поддержку для тонкой настройки серии glm с Muon, так как мы обнаружили, что это делает обучение гораздо более стабильным на модели предварительной тренировки muon. Это хорошо коррелирует с выводами в статье moonlight.

Мы используем реализацию Microsoft в dion

По производительности мы на уровне torchtitan moe training (в основном потому, что мы взяли torchtitan в качестве ориентира для оптимизации нашего кода).

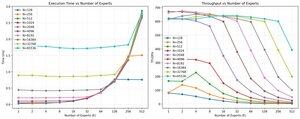

Мы достигаем 20% mfu на 100B glm air moe при обучении с длиной последовательности 65K на 512 h200 gpu с muon. В терминах параллелизма мы обнаружили, что torchtitan EP не так оптимизирован для разреженных MoE и не дает значительного ускорения при достаточно большом размере пакета.

Кажется, что мы можем быстро насытить производительность группового mm ядра для MoE, и что лучшее распределение нагрузки с EP дает убывающую отдачу из-за блокировки all to all.

Мы считаем, что существует много возможностей для улучшения в открытом исходном коде для MoE. Существует сильная необходимость в оптимизированных ядрах, чтобы сделать MoE быстрее и скрыть коммуникацию и вычисления очень детально. Кажется, что это еще более необходимо для blackwell.

ах, также большая часть работы над moe была выполнена @jackminong

20,88K

Топ

Рейтинг

Избранное