Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime-rl a désormais un support étendu pour MoE tant pour RL que pour SFT, nous avons formé un modèle de plus de 100B avec cela

Nous avons le support pour :

* Qwen3 a3-30b

* série GLM et Moonlight

* ajout de la série gpt oss pendant que nous parlons

nous avons fini par réécrire la plupart du code de modélisation pour le faire fonctionner avec torch compile tout en restant compatible avec l'écosystème hugging face

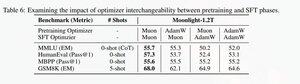

Nous avons également ajouté le support pour affiner la série glm avec Muon, car nous avons constaté que cela rendait l'entraînement beaucoup plus stable sur le modèle préentraîné muon. Cela correspond bien aux résultats trouvés dans le document moonlight.

Nous utilisons l'implémentation de Microsoft dans dion

En termes de performance, nous sommes au même niveau que l'entraînement torchtitan moe (principalement parce que nous avons pris torchtitan comme référence pour optimiser notre code).

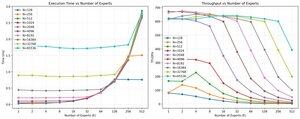

Nous atteignons 20 % de mfu sur le 100B glm air moe avec un entraînement de 65K seq len sur 512 h200 gpu avec muon. En termes de parallélisme, nous avons découvert que l'EP de torchtitan n'est pas vraiment optimisé pour les MoEs épars et n'a pas donné d'accélération significative avec une taille de lot suffisamment grande.

Il semble que nous puissions saturer rapidement la performance du noyau mm de groupe pour les MoEs et que faire un meilleur équilibrage de charge avec l'EP entraîne des rendements décroissants en raison du blocage total.

Nous croyons qu'il y a beaucoup de place pour l'amélioration dans l'ensemble de la pile open source pour les MoEs. Il y a un besoin urgent de noyaux optimisés pour rendre les MoEs plus rapides et pour cacher la communication et le calcul de manière très fine.

ah aussi, la plupart du travail sur moe a été fait par @jackminong

20,88K

Meilleurs

Classement

Favoris