Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime-rl ha ora un ampio supporto per MoE sia per RL che per SFT, abbiamo addestrato un modello da oltre 100B con esso

Abbiamo supporto per:

* Qwen3 a3-30b

* serie GLM e Moonlight

* stiamo aggiungendo la serie gpt oss mentre parliamo

alla fine riscriviamo gran parte del codice di modellazione per farlo funzionare con torch compile pur rimanendo compatibile con l'ecosistema di hugging face

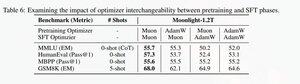

Abbiamo anche aggiunto il supporto per affinare la serie glm con Muon, poiché abbiamo scoperto che rende l'addestramento molto più stabile sul modello di preaddestramento muon. Questo si correla bene con i risultati nel documento moonlight.

Stiamo utilizzando l'implementazione di Microsoft in dion

Dal punto di vista delle prestazioni, siamo alla pari con l'addestramento torchtitan moe (principalmente perché abbiamo preso torchtitan come riferimento per ottimizzare il nostro codice).

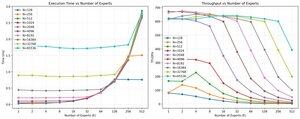

Raggiungiamo il 20% di mfu sul 100B glm air moe con un addestramento di 65K seq len su 512 h200 gpu con muon. In termini di parallelismo, abbiamo scoperto che torchtitan EP non è così ottimizzato per MoE sparse e non ha prodotto alcun significativo aumento di velocità con una dimensione del batch sufficientemente grande.

Sembra che possiamo saturare rapidamente le prestazioni del kernel mm di gruppo per MoE e che un migliore bilanciamento del carico con EP porti a rendimenti decrescenti a causa del blocco all-to-all.

Crediamo che ci sia molto margine di miglioramento nell'intero stack open source per MoE. C'è un forte bisogno di kernel ottimizzati per rendere MoE più veloci e per nascondere la comunicazione e il calcolo in modo molto dettagliato. Sembra essere ancora più necessario per blackwell.

ah anche gran parte del lavoro su moe è stato fatto da @jackminong

19,93K

Principali

Ranking

Preferiti