Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime-rl ma teraz rozbudowane wsparcie dla MoE zarówno dla RL, jak i SFT, trenowaliśmy model 100B+ z jego użyciem

Mamy wsparcie dla:

* Qwen3 a3-30b

* seria GLM i Moonlight

* dodajemy serię gpt oss w trakcie rozmowy

musieliśmy przepisać większość kodu modelowania, aby działał z torch compile, jednocześnie pozostając kompatybilnym z ekosystemem hugging face

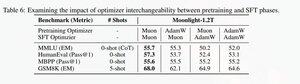

Dodaliśmy również wsparcie do dostrajania serii glm z Muon, ponieważ uznaliśmy, że znacznie stabilizuje to trening na modelu pretrain Muon. To dobrze koreluje z wynikami w artykule moonlight.

Używamy implementacji Microsoftu w dion

Pod względem wydajności jesteśmy na równi z treningiem torchtitan moe (głównie dlatego, że wzięliśmy torchtitan jako punkt odniesienia do optymalizacji naszego kodu).

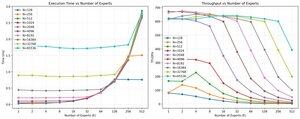

Osiągamy 20% mfu na 100B glm air moe przy treningu na 65K długości sekwencji na 512 h200 gpu z muon. Jeśli chodzi o równoległość, odkryliśmy, że torchtitan EP nie jest zbyt dobrze zoptymalizowany dla rzadkich MoEs i nie przyniósł żadnego znaczącego przyspieszenia przy wystarczająco dużym rozmiarze partii.

Wydaje się, że możemy szybko nasycić wydajność grupowego jądra mm dla MoEs, a lepsze równoważenie obciążenia z EP przynosi malejące korzyści z powodu blokowania wszystkich do wszystkich.

Uważamy, że istnieje wiele możliwości poprawy w całym otwartym stosie dla MoEs. Istnieje silna potrzeba zoptymalizowanych jąder, aby przyspieszyć MoEs i ukryć komunikację oraz obliczenia w bardzo drobny sposób. Wydaje się, że jest to jeszcze bardziej potrzebne dla blackwell.

ah, więc większość pracy nad moe została wykonana przez @jackminong

19,94K

Najlepsze

Ranking

Ulubione