Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

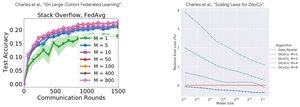

Leistungsanalyse: DiLoCo vs Federated Learning

Gegensätzliche Erkenntnis: Die Leistung von DiLoCo wird SCHLECHTER mit mehr Replikaten (M↑ = Leistung↓), während Federated Learning mit mehr Clients BESSER wird (M↑ = Leistung↑)

Warum die gegensätzlichen Trends?

DiLoCo: Fester Datenbudgetanteil M Wege. Mehr Replikate = Weniger Daten pro Replikat. Daher bleibt die gesamte Rechenleistung konstant (Isoflop-Analyse) und jeder Arbeiter sieht D/M Daten = schlechteres Lernen

Federated Learning: Jeder Client bringt NEUE Daten. Mehr Clients = Mehr einzigartige Gesamtdatensätze. Jeder Client fügt sowohl Rechenleistung als auch frische Daten hinzu. Daher wächst die Gesamtdatenmenge: D₁ + D₂ + ... + Dₘ = besseres Lernen

Wichtige Erkenntnis: Es geht nicht um den Algorithmus - es geht um die Ressourcenbeschränkungen!

Dank des aufschlussreichen Vortrags von @MatharyCharles in Scratch to Scale habe ich viel über DiLoCo und Federated Learning gelernt.

Wenn Sie mehr über DiLoCo, verteiltes Training und Inferenz sowie Parallelität erfahren möchten, schauen Sie sich @TheZachMueller's Scratch to Scale-Klasse oder eine dieser Ressourcen unten an:

Quellen:

DiLoCo:

Federated Learning:

Scratch to Scale:

#MachineLearning #DistributedTraining #AI

Top

Ranking

Favoriten