Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

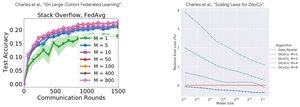

Prestandaanalys: DiLoCo vs federerad inlärning

Kontraintuitiv upptäckt: DiLoCo-prestanda blir SÄMRE med fler repliker (M↑ = prestanda↓), medan federerad inlärning blir BÄTTRE med fler klienter (M↑ = prestanda↑)

Varför de motsatta trenderna?

DiLoCo: Fast databudget uppdelad på olika sätt. Fler repliker = Mindre data per replik. Därför förblir den totala beräkningen konstant (isoflop-analys) och varje arbetare ser D/M-data = sämre inlärning

Federerad inlärning: Varje klient tar med sig NYA data. Fler klienter = Fler totala unika datauppsättningar. Varje klient lägger till både beräkning OCH nya data. Därför växer den totala datamängden: D₁ + D₂ + ... + Dm = bättre inlärning

Viktig insikt: Det handlar inte om algoritmen - det handlar om resursbegränsningarna!

Tack vare det upplysande samtalet om @MatharyCharles in Scratch to Scale har jag lärt mig mycket om DiLoCo och Federated Learning .

Om du är intresserad av att lära dig mer om DiLoCo, distribuerad träning och slutsatsdragning och parallellitet kan du kolla in @TheZachMueller:s Scratch to Scale-klass eller någon av dessa resurser nedan:

Källor:

DiLoCo:

Federerad inlärning:

Skrapa till skala:

#MachineLearning #DistributedTraining #AI

Topp

Rankning

Favoriter