Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

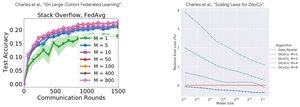

Анализ производительности: DiLoCo против Федеративного обучения

Противоречивое открытие: производительность DiLoCo УХУДШАЕТСЯ с увеличением числа реплик (M↑ = производительность↓), в то время как Федеративное обучение УЛУЧШАЕТСЯ с увеличением числа клиентов (M↑ = производительность↑)

Почему противоположные тенденции?

DiLoCo: фиксированный бюджет данных делится M способами. Больше реплик = меньше данных на реплику. Следовательно, общее вычисление остается постоянным (анализ изофлопов), и каждый работник видит D/M данных = худшее обучение

Федеративное обучение: каждый клиент приносит НОВЫЕ данные. Больше клиентов = больше уникальных наборов данных. Каждый клиент добавляет как вычисления, так и свежие данные. Следовательно, общее количество данных растет: D₁ + D₂ + ... + Dₘ = лучшее обучение

Ключевая идея: дело не в алгоритме - дело в ресурсных ограничениях!

Благодаря просветительскому докладу @MatharyCharles на Scratch to Scale, я многому научился о DiLoCo и Федеративном обучении.

Если вы хотите узнать больше о DiLoCo, распределенном обучении и выводе и параллелизме, ознакомьтесь с классом @TheZachMueller на Scratch to Scale или любыми из следующих ресурсов:

Источники:

DiLoCo:

Федеративное обучение:

Scratch to Scale:

#MachineLearning #DistributedTraining #AI

Топ

Рейтинг

Избранное