Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

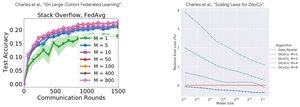

Analisis Kinerja: DiLoCo vs Pembelajaran Federasi

Temuan kontra-intuisi: Kinerja DiLoCo menjadi LEBIH BURUK dengan lebih banyak replika (M↑ = kinerja↓), sedangkan Pembelajaran Federasi menjadi LEBIH BAIK dengan lebih banyak klien (M↑ = kinerja↑)

Mengapa tren yang berlawanan?

DiLoCo: Anggaran data tetap membagi M cara. Lebih banyak replika = Lebih sedikit data per replika. Oleh karena itu, komputasi total tetap konstan (analisis isoflop) dan setiap pekerja melihat data D/M = pembelajaran yang lebih buruk

Pembelajaran Federasi: Setiap klien membawa data BARU. Lebih banyak klien = Lebih banyak kumpulan data unik total. Setiap klien menambahkan komputasi DAN data baru. Oleh karena itu, total data bertambah: D₁ + D₂ + ... + Dm = pembelajaran yang lebih baik

Wawasan kunci: Ini bukan tentang algoritma - ini tentang kendala sumber daya!

Berkat pembicaraan yang mencerahkan tentang @MatharyCharles di Scratch to Scale, saya telah belajar banyak tentang DiLoCo dan Federated Learning .

Jika Anda tertarik untuk mempelajari lebih lanjut tentang DiLoCo, pelatihan terdistribusi dan inferensi dan paralelisme, lihat kelas Scratch to Scale @TheZachMueller atau salah satu sumber daya di bawah ini:

Sumber:

DiLoCo:

Pembelajaran Federasi:

Goresan ke Skala:

#MachineLearning #DistributedTraining #AI

Teratas

Peringkat

Favorit