Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

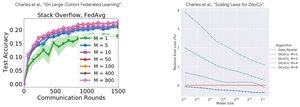

Analisi delle prestazioni: DiLoCo vs Federated Learning

Risultato controintuitivo: le prestazioni di DiLoCo peggiorano con più repliche (M↑ = prestazioni↓), mentre il Federated Learning migliora con più clienti (M↑ = prestazioni↑)

Perché le tendenze opposte?

DiLoCo: budget dati fisso diviso in M modi. Più repliche = meno dati per replica. Pertanto, il calcolo totale rimane costante (analisi isoflop) e ogni lavoratore vede D/M dati = apprendimento peggiore

Federated Learning: ogni cliente porta NUOVI dati. Più clienti = più dataset unici totali. Ogni cliente aggiunge sia calcolo CHE dati freschi. Pertanto, i dati totali crescono: D₁ + D₂ + ... + Dₘ = apprendimento migliore

Insight chiave: non si tratta dell'algoritmo - si tratta dei vincoli delle risorse!

Grazie alla illuminante conferenza di @MatharyCharles in Scratch to Scale, ho imparato molto su DiLoCo e Federated Learning.

Se sei interessato a saperne di più su DiLoCo, addestramento e inferenza distribuiti e parallelismo, dai un'occhiata alla classe Scratch to Scale di @TheZachMueller o a una di queste risorse qui sotto:

Fonti:

DiLoCo:

Federated Learning:

Scratch to Scale:

#MachineLearning #DistributedTraining #AI

Principali

Ranking

Preferiti