Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

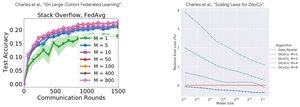

Análisis de rendimiento: DiLoCo vs Aprendizaje Federado

Hallazgo contraintuitivo: el rendimiento de DiLoCo empeora con más réplicas (M↑ = rendimiento↓), mientras que el Aprendizaje Federado mejora con más clientes (M↑ = rendimiento↑)

¿Por qué las tendencias opuestas?

DiLoCo: Presupuesto de datos fijo dividido en M partes. Más réplicas = Menos datos por réplica. Por lo tanto, el cómputo total se mantiene constante (análisis isoflop) y cada trabajador ve D/M datos = peor aprendizaje

Aprendizaje Federado: Cada cliente aporta NUEVOS datos. Más clientes = Más conjuntos de datos únicos totales. Cada cliente añade tanto cómputo COMO datos frescos. Por lo tanto, el total de datos crece: D₁ + D₂ + ... + Dₘ = mejor aprendizaje

Perspectiva clave: ¡No se trata del algoritmo, se trata de las limitaciones de recursos!

Gracias a la charla esclarecedora de @MatharyCharles en Scratch to Scale, he aprendido mucho sobre DiLoCo y Aprendizaje Federado.

Si estás interesado en aprender más sobre DiLoCo, entrenamiento e inferencia distribuidos y paralelismo, consulta la clase Scratch to Scale de @TheZachMueller o cualquiera de estos recursos a continuación:

Fuentes:

DiLoCo:

Aprendizaje Federado:

Scratch to Scale:

#MachineLearning #DistributedTraining #AI

Parte superior

Clasificación

Favoritos