Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

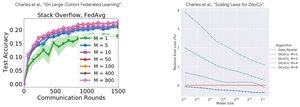

Аналіз продуктивності: DiLoCo проти федеративного навчання

Парадоксальний висновок: продуктивність DiLoCo стає ГІРШОЮ з більшою кількістю реплік (M↑ = продуктивність↓), тоді як Federated Learning стає КРАЩОЮ з більшою кількістю клієнтів (M↑ = продуктивність↑)

Чому саме протилежні тенденції?

DiLoCo: Фіксований розподіл бюджету даних на M шляхів. Більше реплік = менше даних на репліку. Отже, загальні обчислення залишаються незмінними (ізофлоп-аналіз), і кожен працівник бачить D/M дані = гірше навчання

Федеративне навчання: Кожен клієнт приносить НОВІ дані. Більше клієнтів = більше загальних унікальних наборів даних. Кожен клієнт додає як обчислювальні, так і свіжі дані. Отже, зростає загальна кількість даних: D₁ + D₂ + ... + Dm = краще навчання

Ключовий інсайт: справа не в алгоритмі, а в ресурсних обмеженнях!

Завдяки просвітницьким розмовам про @MatharyCharles в Scratch to Scale, я багато чому навчився на DiLoCo та Federated Learning .

Якщо вам цікаво дізнатися більше про DiLoCo, розподілене навчання та висновування та паралелізм, перегляньте клас Scratch to Scale від @TheZachMueller або будь-який з цих ресурсів нижче:

Джерел:

DiLoCo:

Федеративне навчання:

Скретч у масштабі:

#MachineLearning #DistributedTraining #AI

Найкращі

Рейтинг

Вибране