Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

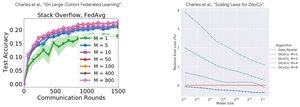

Ytelsesanalyse: DiLoCo vs føderert læring

Kontraintuitivt funn: DiLoCo-ytelsen blir DÅRLIGERE med flere replikaer (M↑ = ytelse↓), mens Federated Learning blir BEDRE med flere klienter (M↑ = ytelse↑)

Hvorfor de motsatte trendene?

DiLoCo: Fast databudsjett delt M måter. Flere replikaer = Mindre data per replika. Derfor forblir total databehandling konstant (isoflop-analyse) og hver arbeider ser D/M-data = dårligere læring

Federated Learning: Hver klient bringer NYE data. Flere klienter = Flere unike datasett totalt. Hver klient legger til både databehandling OG ferske data. Derfor vokser de totale dataene: D₁ + D₂ + ... + Dm = bedre læring

Hovedinnsikt: Det handler ikke om algoritmen - det handler om ressursbegrensningene!

Takket være det opplysende snakket om @MatharyCharles i Scratch to Scale, har jeg lært mye om DiLoCo og Federated Learning.

Hvis du er interessert i å lære mer om DiLoCo, distribuert opplæring og slutning og parallellitet, sjekk ut @TheZachMueller's Scratch to Scale-klasse eller noen av disse ressursene nedenfor:

Kilder:

DiLoCo:

Føderert læring:

Skrap til skala:

#MachineLearning #DistributedTraining #AI

Topp

Rangering

Favoritter