Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

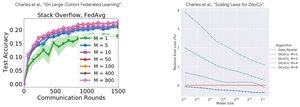

Prestatieanalyse: DiLoCo vs Federated Learning

Tegenintuïtieve bevinding: DiLoCo-prestaties worden SLECHTER met meer replica's (M↑ = prestatie↓), terwijl Federated Learning BETER wordt met meer klanten (M↑ = prestatie↑)

Waarom de tegenovergestelde trends?

DiLoCo: Vaste databudgetverdeling M manieren. Meer replica's = Minder data per replica. Daarom blijft de totale rekencapaciteit constant (isoflop-analyse) en ziet elke werker D/M data = slechter leren

Federated Learning: Elke klant brengt NIEUWE data. Meer klanten = Meer totale unieke datasets. Elke klant voegt zowel rekencapaciteit ALS verse data toe. Daarom groeit de totale data: D₁ + D₂ + ... + Dₘ = beter leren

Belangrijk inzicht: Het gaat niet om het algoritme - het gaat om de hulpbronnenbeperkingen!

Dank aan de verhelderende lezing van @MatharyCharles in Scratch to Scale, ik heb veel geleerd over DiLoCo en Federated Learning.

Als je geïnteresseerd bent in het leren over DiLoCo, gedistribueerde training en inferentie en parallelisme, kijk dan naar @TheZachMueller's Scratch to Scale-cursus of een van deze bronnen hieronder:

Bronnen:

DiLoCo:

Federated Learning:

Scratch to Scale:

#MachineLearning #DistributedTraining #AI

Boven

Positie

Favorieten