热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

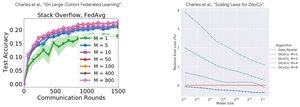

性能分析:DiLoCo 与联邦学习

反直觉的发现:DiLoCo 的性能随着副本数量的增加而变差(M↑ = 性能↓),而联邦学习随着客户端数量的增加而变好(M↑ = 性能↑)

为什么会有相反的趋势?

DiLoCo:固定的数据预算分配为 M 份。更多的副本 = 每个副本的数据更少。因此,总计算保持不变(等效浮点分析),每个工作者看到的数据为 D/M = 学习效果更差

联邦学习:每个客户端带来新的数据。更多的客户端 = 更多的独特数据集。每个客户端同时增加计算和新数据。因此,总数据增长:D₁ + D₂ + ... + Dₘ = 学习效果更好

关键见解:这不是关于算法 - 而是关于资源限制!

感谢 @MatharyCharles 在 Scratch to Scale 的启发性演讲,我在 DiLoCo 和联邦学习方面学到了很多。

如果你对了解更多关于 DiLoCo、分布式训练和推理以及并行性感兴趣,请查看 @TheZachMueller 的 Scratch to Scale 课程或以下任何资源:

来源:

DiLoCo:

联邦学习:

Scratch to Scale:

#MachineLearning #DistributedTraining #AI

热门

排行

收藏