Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

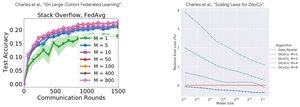

Analiza performanței: DiLoCo vs Federated Learning

Constatare contraintuitivă: performanța DiLoCo se înrăutățește cu mai multe replici (M↑ = performanță↓), în timp ce Federated Learning devine MAI BUNĂ cu mai mulți clienți (M↑ = performanță↑)

De ce tendințele opuse?

DiLoCo: Buget fix de date împărțit în moduri M. Mai multe replici = Mai puține date per replică. Prin urmare, calculul total rămâne constant (analiza izoflop) și fiecare lucrător vede date D/M = învățare mai slabă

Federated Learning: Fiecare client aduce date NOI. Mai mulți clienți = Mai multe seturi de date unice. Fiecare client adaugă atât date de calcul, cât și date proaspete. Prin urmare, datele totale cresc: D₁ + D₂ + ... + Dm = învățare mai bună

Informații cheie: Nu este vorba despre algoritm - este vorba despre constrângerile de resurse!

Datorită discuției edificatoare despre @MatharyCharles în Scratch to Scale, am învățat multe despre DiLoCo și Federated Learning.

Dacă sunteți interesat să aflați mai multe despre DiLoCo, instruire distribuită și inferență și paralelism, consultați clasa Scratch to Scale @TheZachMueller sau oricare dintre aceste resurse de mai jos:

Surse:

DiLoCo:

Învățare federativă:

Scratch la scară:

#MachineLearning #DistributedTraining #AI

Limită superioară

Clasament

Favorite