トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

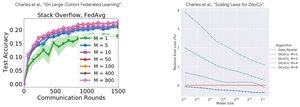

パフォーマンス分析:DiLoCoとフェデレーテッドラーニング

直感に反する発見:DiLoCoのパフォーマンスはレプリカが多いほど悪くなります(M↑=パフォーマンス↓)、フェデレーテッドラーニングはクライアント数が多いほど良くなります(M↑=パフォーマンス↑)

なぜ反対の傾向なのでしょうか?

DiLoCo: データ予算を M 方向に分割しました。レプリカの数が多い = レプリカあたりのデータが少ない。したがって、合計計算は一定に保たれ(アイソフロップ分析)、各ワーカーはD/Mデータを見る=学習が悪い

フェデレーテッドラーニング:各クライアントは新しいデータをもたらします。より多くのクライアント = より多くのユニークデータセット。各クライアントは、コンピューティング データと新しいデータの両方を追加します。したがって、総データは増加します: D₁ + D₂ + ... + Dm = より良い学習

重要な洞察: それはアルゴリズムの問題ではなく、リソースの制約に関するものです。

Scratch to Scaleの@MatharyCharlesの啓発的な話のおかげで、私はDiLoCoとFederated Learningについて多くのことを学びました。

DiLoCo、分散トレーニング、推論、並列処理について詳しく知りたい場合は、@TheZachMuellerの Scratch to Scale クラスまたは以下のリソースをご覧ください。

ソース:

ディロコ:

フェデレーテッドラーニング:

スクラッチからスケールへ:

#MachineLearning #DistributedTraining #AI

トップ

ランキング

お気に入り