Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Wie trainiert man kleine Denkmodelle effektiver?

Das ist ein Problem, mit dem viele KI-Entwickler konfrontiert sind. Das Feintuning mit RL neigt im Allgemeinen dazu, zu stagnieren, insbesondere bei Modellen mit 1–2B.

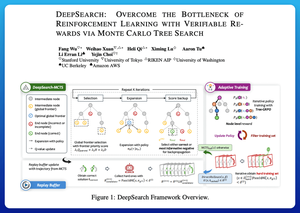

Ich denke, DeepSearch bietet hier einen wirklich sauberen Ansatz. Es nimmt die Idee der Monte Carlo Baum-Suche (MCTS) während der Inferenz und integriert sie in die Trainingsschleife. Dieser Wechsel ermöglicht eine bessere Erkundung und effizienteres Lernen.

Hier sind meine Notizen aus dem Papier:

Die Schleife umfasst vier Schlüsselideen:

Suche während des Trainings: Anstatt nur zur Testzeit zu suchen, wird MCTS während des RL-Trainings ausgeführt. Ein lokaler UCT-Selektor bewertet Geschwister, während ein globaler Grenzwert-Scorer vielversprechende Blätter im gesamten Baum basierend auf dem Wert des Elternteils, der Entropie und der Tiefe auswählt.

Lernen aus Siegen und selbstbewussten Fehlern: Wenn eine korrekte Lösung nicht gefunden wird, lernt das Modell trotzdem, indem es den selbstbewussten falschen Weg (Fehler mit der niedrigsten Entropie) überwacht. Korrekte Wege bleiben während der Updates nicht negativ, was bei der Schritt-für-Schritt-Zuordnung von Anerkennung hilft.

Stabilisierung von RL mit Tree-GRPO: Sie verfeinern PPO-ähnliche Ziele mit Knoten-q-Werten, nur Mittelwert-Normalisierung und einer sanften Clipping-Strategie. Dies vermeidet Belohnungsexplosionen, während die Gradienten informativ bleiben.

Effizient bleiben: Um verschwendete Rechenleistung zu reduzieren, filtert DeepSearch auf eine harte Teilmenge von Problemen, speichert Lösungen, sobald sie verifiziert sind, und überspringt die vollständige Suche, wenn eine Antwort bereits bekannt ist.

All diese Verbesserungen führen zu starken Ergebnissen.

DeepSearch-1.5B erreicht 62,95 % bei den AIME/AMC-Benchmarks und übertrifft eine Top-Nemotron-Basislinie, während es nur ~330 GPU-Stunden verwendet. Im Vergleich dazu stagniert das normale RL-Training selbst bei über 1.800 GPU-Stunden niedriger.

Papier:

Ich denke, dieses Papier bietet ein praktisches Rezept, um Durchbrüche bei kleinen Denk-LMs zu erzielen:

• Suche ins Training verlagern, nicht nur in die Inferenz

• Sowohl richtige als auch falsche Wege überwachen

• Globale Priorisierung nutzen, um intelligenter zu erkunden

• Cachen und filtern, um die Effizienz hoch zu halten

Top

Ranking

Favoriten