Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Come si addestrano i modelli di ragionamento piccoli in modo più efficace?

Questo è un problema con cui molti sviluppatori di AI si scontrano. Il fine-tuning RL, in generale, tende a stabilizzarsi, specialmente per modelli da 1 a 2 miliardi.

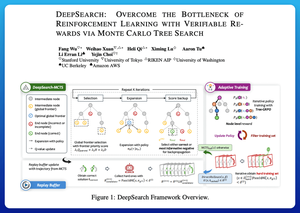

Penso che DeepSearch offra un approccio davvero pulito qui. Prende l'idea della Ricerca ad Albero di Monte Carlo (MCTS) durante l'inferenza e la sposta nel ciclo di addestramento. Questo cambiamento sblocca una migliore esplorazione e un apprendimento più efficiente.

Ecco le mie note dal documento:

Il ciclo coinvolge quattro idee chiave:

Ricerca Durante l'Addestramento: Invece di fare ricerca solo al momento del test, MCTS viene eseguito durante l'addestramento RL. Un selettore UCT locale classifica i fratelli, mentre un valutatore globale della frontiera sceglie foglie promettenti in tutto l'albero basandosi sul valore del genitore, sull'entropia e sulla profondità.

Apprendere da Entrambi i Successi e gli Errori Sicuri: Se non viene trovata una soluzione corretta, il modello impara comunque supervisionando il percorso errato sicuro (errori a bassa entropia). I percorsi corretti rimangono non negativi durante gli aggiornamenti, il che aiuta con l'assegnazione del credito a livello di passo.

Stabilizzare il RL con Tree-GRPO: Raffinano gli obiettivi in stile PPO con valori q a livello di nodo, normalizzazione solo media e una strategia di clipping morbido. Questo evita esplosioni di ricompensa mantenendo informativi i gradienti.

Rimanere Efficiente: Per ridurre il calcolo sprecato, DeepSearch filtra a un sottoinsieme rigoroso di problemi, memorizza le soluzioni una volta verificate e salta la ricerca completa quando una risposta è già nota.

Tutti questi miglioramenti portano a risultati forti.

DeepSearch-1.5B raggiunge il 62,95% nei benchmark AIME/AMC, superando un top baseline di Nemotron utilizzando solo ~330 ore GPU. In confronto, il normale addestramento RL si stabilizza più in basso anche con oltre 1.800 ore GPU.

Documento:

Penso che questo documento offra una ricetta pratica per superare i plateau nei LMs di ragionamento piccoli:

• Sposta la ricerca nell'addestramento, non solo nell'inferenza

• Supervisiona sia i percorsi giusti che quelli sbagliati

• Usa la priorità globale per esplorare in modo più intelligente

• Memorizza e filtra per mantenere alta l'efficienza

Principali

Ranking

Preferiti