Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

¿Cómo entrenas modelos de razonamiento pequeños de manera más efectiva?

Este es un problema con el que muchos desarrolladores de IA se encuentran. El ajuste fino por refuerzo (RL), en general, tiende a estancarse, especialmente para modelos de 1 a 2B.

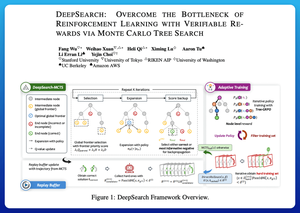

Creo que DeepSearch ofrece un enfoque realmente limpio aquí. Toma la idea de la Búsqueda de Árbol de Monte Carlo (MCTS) en la inferencia y la mueve al bucle de entrenamiento. Ese cambio desbloquea una mejor exploración y un aprendizaje más eficiente.

Aquí están mis notas del artículo:

El bucle involucra cuatro ideas clave:

Buscar Durante el Entrenamiento: En lugar de solo hacer búsqueda en el momento de la prueba, MCTS se ejecuta durante el entrenamiento de RL. Un selector UCT local clasifica a los hermanos, mientras que un evaluador de frontera global elige hojas prometedoras en todo el árbol basado en el valor del padre, la entropía y la profundidad.

Aprender de Ambas Victorias y Errores Confiados: Si no se encuentra una solución correcta, el modelo aún aprende supervisando el camino erróneo confiado (errores de menor entropía). Los caminos correctos permanecen no negativos durante las actualizaciones, lo que ayuda con la asignación de crédito a nivel de paso.

Estabilizando RL con Tree-GRPO: Refinan los objetivos estilo PPO con valores q a nivel de nodo, normalización solo media y una estrategia de recorte suave. Esto evita explosiones de recompensa mientras mantiene informativos los gradientes.

Manteniéndose Eficiente: Para reducir el cómputo desperdiciado, DeepSearch filtra a un subconjunto duro de problemas, almacena soluciones una vez que se verifican y omite la búsqueda completa cuando ya se conoce una respuesta.

Todas estas mejoras conducen a resultados sólidos.

DeepSearch-1.5B alcanza un 62.95% en los benchmarks AIME/AMC, superando una línea base de Nemotron mientras utiliza solo ~330 horas de GPU. En comparación, el entrenamiento normal de RL se estanca más bajo incluso con más de 1,800 horas de GPU.

Artículo:

Creo que este artículo ofrece una receta práctica para romper los estancamientos en los LMs de razonamiento pequeños:

• Mover la búsqueda al entrenamiento, no solo a la inferencia

• Supervisar tanto los caminos correctos como los incorrectos

• Usar priorización global para explorar de manera más inteligente

• Almacenar en caché y filtrar para mantener alta la eficiencia

Parte superior

Clasificación

Favoritos