Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Làm thế nào để bạn huấn luyện các mô hình lý luận nhỏ một cách hiệu quả hơn?

Đây là một vấn đề mà nhiều nhà phát triển AI gặp phải. Việc tinh chỉnh RL, nói chung, có xu hướng đạt đến điểm bão hòa, đặc biệt là đối với các mô hình 1–2B.

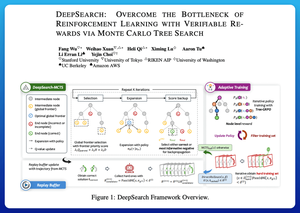

Tôi nghĩ DeepSearch cung cấp một cách tiếp cận rất rõ ràng ở đây. Nó lấy ý tưởng của Tìm kiếm Cây Monte Carlo (MCTS) trong suy diễn và đưa nó vào vòng lặp huấn luyện. Sự chuyển đổi đó mở khóa khả năng khám phá tốt hơn và việc học hiệu quả hơn.

Dưới đây là ghi chú của tôi từ bài báo:

Vòng lặp bao gồm bốn ý tưởng chính:

Tìm kiếm trong quá trình huấn luyện: Thay vì chỉ thực hiện tìm kiếm vào thời điểm kiểm tra, MCTS được chạy trong quá trình huấn luyện RL. Một bộ chọn UCT cục bộ xếp hạng các anh em, trong khi một bộ điểm biên toàn cầu chọn các lá hứa hẹn trên toàn bộ cây dựa trên giá trị cha, độ hỗn loạn và độ sâu.

Học từ cả chiến thắng và những sai lầm tự tin: Nếu không tìm thấy giải pháp đúng, mô hình vẫn học bằng cách giám sát con đường sai lầm tự tin (những sai lầm có độ hỗn loạn thấp nhất). Các con đường đúng vẫn giữ giá trị không âm trong quá trình cập nhật, điều này giúp với việc phân bổ tín dụng theo từng bước.

Ổn định RL với Tree-GRPO: Họ tinh chỉnh các mục tiêu kiểu PPO với các giá trị q cấp nút, chuẩn hóa chỉ trung bình và một chiến lược cắt mềm. Điều này tránh được sự bùng nổ phần thưởng trong khi vẫn giữ cho các gradient có thông tin.

Giữ cho hiệu quả: Để cắt giảm tính toán lãng phí, DeepSearch lọc ra một tập hợp vấn đề cứng, lưu trữ các giải pháp một khi chúng đã được xác minh, và bỏ qua tìm kiếm đầy đủ khi một câu trả lời đã được biết.

Tất cả những cải tiến này dẫn đến kết quả mạnh mẽ.

DeepSearch-1.5B đạt 62.95% trên các tiêu chuẩn AIME/AMC, vượt qua một cơ sở Nemotron hàng đầu trong khi chỉ sử dụng khoảng ~330 giờ GPU. So với đó, việc huấn luyện RL bình thường đạt đến điểm bão hòa thấp hơn ngay cả với hơn 1,800 giờ GPU.

Bài báo:

Tôi nghĩ bài báo này cung cấp một công thức thực tiễn để vượt qua các điểm bão hòa trong các mô hình lý luận nhỏ:

• Di chuyển tìm kiếm vào huấn luyện, không chỉ suy diễn

• Giám sát cả con đường đúng và sai

• Sử dụng ưu tiên toàn cầu để khám phá thông minh hơn

• Lưu trữ và lọc để giữ cho hiệu quả cao

Hàng đầu

Thứ hạng

Yêu thích