熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

如何更有效地訓練小型推理模型?

這是許多 AI 開發者面臨的問題。強化學習微調通常會遇到瓶頸,特別是對於 1–2B 的模型。

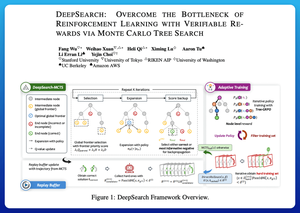

我認為 DeepSearch 在這方面提供了一個非常清晰的方法。它將蒙特卡羅樹搜索(MCTS)的概念從推理階段移入訓練循環中。這一轉變解鎖了更好的探索和更高效的學習。

以下是我從論文中整理的筆記:

這個循環涉及四個關鍵概念:

訓練期間的搜索:在測試時不僅僅進行搜索,MCTS 在強化學習訓練期間運行。一個局部的 UCT 選擇器對兄弟節點進行排名,而一個全局的邊界評分器根據父節點的價值、熵和深度選擇有前景的葉子。

從勝利和自信的錯誤中學習:如果沒有找到正確的解決方案,模型仍然可以通過監督自信的錯誤路徑(最低熵的錯誤)來學習。正確的路徑在更新期間保持非負,這有助於逐步的信用分配。

用 Tree-GRPO 穩定強化學習:他們用節點級的 q 值、僅均值的正規化和柔性裁剪策略來改進 PPO 風格的目標。這避免了獎勵爆炸,同時保持梯度的信息性。

保持高效:為了減少浪費的計算,DeepSearch 過濾到一個硬性問題子集,驗證後緩存解決方案,並在已知答案的情況下跳過完整搜索。

所有這些改進都導致了強勁的結果。

DeepSearch-1.5B 在 AIME/AMC 基準測試中達到 62.95%,超越了頂級的 Nemotron 基準,同時僅使用了約 330 GPU 小時。相比之下,正常的強化學習訓練即使使用 1,800+ GPU 小時也會達到較低的瓶頸。

論文:

我認為這篇論文提供了一個實用的配方,可以突破小型推理 LMs 的瓶頸:

• 將搜索移入訓練,而不僅僅是推理

• 監督正確和錯誤的路徑

• 使用全局優先級進行更智能的探索

• 緩存和過濾以保持高效率

熱門

排行

收藏