Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Comment former des modèles de raisonnement petits de manière plus efficace ?

C'est un problème auquel de nombreux développeurs d'IA sont confrontés. Le fine-tuning par RL, en général, tend à se stabiliser, surtout pour les modèles de 1 à 2 milliards.

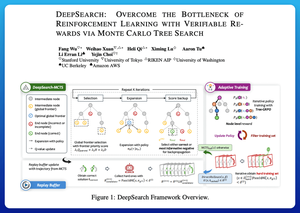

Je pense que DeepSearch propose une approche vraiment claire ici. Il prend l'idée de la recherche d'arbre de Monte Carlo (MCTS) lors de l'inférence et l'intègre dans la boucle d'entraînement. Ce changement permet une meilleure exploration et un apprentissage plus efficace.

Voici mes notes tirées de l'article :

La boucle implique quatre idées clés :

Recherche pendant l'entraînement : Au lieu de ne faire de la recherche qu'au moment du test, MCTS est exécuté pendant l'entraînement RL. Un sélecteur UCT local classe les frères et sœurs, tandis qu'un scoreur de frontière global choisit des feuilles prometteuses dans tout l'arbre en fonction de la valeur parent, de l'entropie et de la profondeur.

Apprendre à partir des victoires et des erreurs confiantes : Si une solution correcte n'est pas trouvée, le modèle apprend tout de même en supervisant le chemin erroné confiant (erreurs à faible entropie). Les chemins corrects restent non négatifs pendant les mises à jour, ce qui aide à l'attribution de crédit au niveau des étapes.

Stabiliser le RL avec Tree-GRPO : Ils affinent les objectifs de style PPO avec des valeurs q au niveau des nœuds, une normalisation uniquement moyenne et une stratégie de clipping douce. Cela évite les explosions de récompenses tout en gardant les gradients informatifs.

Rester efficace : Pour réduire le calcul gaspillé, DeepSearch filtre un sous-ensemble difficile de problèmes, met en cache les solutions une fois qu'elles sont vérifiées et saute la recherche complète lorsqu'une réponse est déjà connue.

Toutes ces améliorations conduisent à de bons résultats.

DeepSearch-1.5B atteint 62,95 % sur les benchmarks AIME/AMC, battant une référence Nemotron de premier plan tout en n'utilisant que ~330 heures GPU. En comparaison, l'entraînement RL normal se stabilise plus bas même avec plus de 1 800 heures GPU.

Article :

Je pense que cet article offre une recette pratique pour surmonter les plateaux dans les LMs de raisonnement petits :

• Déplacer la recherche dans l'entraînement, pas seulement dans l'inférence

• Superviser à la fois les bons et les mauvais chemins

• Utiliser la priorisation globale pour explorer plus intelligemment

• Mettre en cache et filtrer pour maintenir une efficacité élevée.

Meilleurs

Classement

Favoris