Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Як ефективніше тренувати маленькі моделі міркувань?

Це проблема, з якою стикаються багато розробників штучного інтелекту. Тонке налаштування RL, в цілому, має тенденцію до плато, особливо це стосується моделей 1-2В.

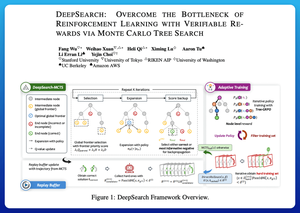

Я вважаю, що DeepSearch пропонує дійсно чистий підхід. Він бере ідею пошуку дерева Монте-Карло (MCTS) на виведенні та переміщує її в цикл навчання. Цей зсув відкриває доступ до кращого дослідження та ефективнішого навчання.

Ось мої нотатки з газети:

Цикл включає в себе чотири ключові ідеї:

Пошук під час тренування: Замість того, щоб виконувати пошук лише під час тестування, MCTS виконується під час тренування RL. Місцевий селектор UCT ранжує братів і сестер, тоді як глобальний бомбардир вибирає перспективні листя по всьому дереву на основі батьківського значення, ентропії та глибини.

Навчання як на перемогах, так і на впевнених помилках: якщо правильне рішення не знайдено, модель все одно навчається, контролюючи впевнений неправильний шлях (помилки з найнижчим рівнем ентропії). Правильні шляхи залишаються невід'ємними під час оновлень, що допомагає з поетапним призначенням кредитів.

Стабілізація RL за допомогою Tree-GRPO: вони уточнюють цілі в стилі PPO за допомогою q-значень на рівні вузлів, нормалізації лише середнього значення та стратегії м'якого відсікання. Це дозволяє уникнути нагородних вибухів, зберігаючи при цьому інформативність градієнтів.

Залишаючись ефективним: щоб скоротити марні обчислення, DeepSearch фільтрує складну підмножину проблем, кешує рішення після їх перевірки та пропускає повний пошук, коли відповідь уже відома.

Всі ці поліпшення призводять до високих результатів.

DeepSearch-1.5B досягає 62,95% за тестами AIME/AMC, перевершуючи найвищий базовий рівень Nemotron, використовуючи лише ~330 годин графічного процесора. Для порівняння, звичайні тренувальні плато RL знижуються навіть при 1,800+ годин GPU.

Папір:

Я думаю, що ця стаття пропонує практичний рецепт подолання плато в невеликих міркуваннях ЛМ:

• Переводьте пошук у навчання, а не лише в умовивід

• Контролюйте як правильні, так і неправильні шляхи

• Використовуйте глобальну пріоритезацію, щоб досліджувати розумніше

• Кеш і фільтр для підтримки високої ефективності

Найкращі

Рейтинг

Вибране