Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hvordan trener du små resonneringsmodeller mer effektivt?

Dette er et problem mange AI-utviklere støter på. RL-finjustering har generelt en tendens til å flate ut, spesielt for 1–2B-modeller.

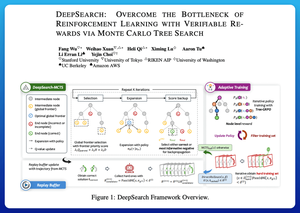

Jeg tror DeepSearch tilbyr en veldig ren tilnærming her. Den tar ideen om Monte Carlo Tree Search (MCTS) ved slutning og flytter den inn i treningssløyfen. Dette skiftet låser opp bedre utforskning og mer effektiv læring.

Her er notatene mine fra avisen:

Sløyfen involverer fire hovedideer:

Søk under opplæring: I stedet for bare å gjøre søk på testtidspunktet, kjøres MCTS under RL-trening. En lokal UCT-velger rangerer søsken, mens en global grensescorer velger lovende blader over hele treet basert på foreldreverdi, entropi og dybde.

Lære av både seire og sikre feil: Hvis en riktig løsning ikke blir funnet, lærer modellen fortsatt ved å overvåke den sikre feil veien (laveste entropifeil). Riktige baner forblir ikke-negative under oppdateringer, noe som hjelper med kreditttildeling på trinnnivå.

Stabilisering av RL med Tree-GRPO: De avgrenser mål i PPO-stil med q-verdier på nodenivå, normalisering av kun gjennomsnitt og en myk klippestrategi. Dette unngår belønningseksplosjoner samtidig som gradientene holdes informative.

Holde seg effektiv: For å redusere bortkastet databehandling filtrerer DeepSearch til et hardt delsett av problemer, bufrer løsninger når de er bekreftet, og hopper over fullt søk når et svar allerede er kjent.

Alle disse forbedringene fører til sterke resultater.

DeepSearch-1.5B når 62,95 % på AIME/AMC-benchmarks, og slår en topp Nemotron-baseline mens den bare bruker ~330 GPU-timer. Til sammenligning senkes normal RL-trening selv med 1,800+ GPU-timer.

Papir:

Jeg tror denne artikkelen tilbyr en praktisk oppskrift for å bryte gjennom platåer i små resonnerende LM-er:

• Flytt søk til trening, ikke bare slutning

• Overvåke både rett og gal vei

• Bruk global prioritering for å utforske smartere

• Cache og filter for å holde effektiviteten høy

Topp

Rangering

Favoritter