Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Como treinar modelos de raciocínio pequenos de forma mais eficaz?

Este é um problema com o qual muitos desenvolvedores de IA se deparam. O ajuste fino por RL, em geral, tende a estagnar, especialmente para modelos de 1 a 2 bilhões.

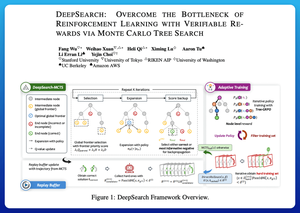

Acho que o DeepSearch oferece uma abordagem realmente limpa aqui. Ele pega a ideia da Busca em Árvore de Monte Carlo (MCTS) na inferência e a move para o loop de treinamento. Essa mudança desbloqueia uma melhor exploração e um aprendizado mais eficiente.

Aqui estão minhas anotações do artigo:

O loop envolve quatro ideias principais:

Busca Durante o Treinamento: Em vez de fazer busca apenas no momento do teste, o MCTS é executado durante o treinamento de RL. Um seletor UCT local classifica os irmãos, enquanto um avaliador de fronteira global escolhe folhas promissoras em toda a árvore com base no valor do pai, entropia e profundidade.

Aprendendo com Vitórias e Erros Confiantes: Se uma solução correta não for encontrada, o modelo ainda aprende supervisionando o caminho errado confiante (erros de menor entropia). Caminhos corretos permanecem não negativos durante as atualizações, o que ajuda na atribuição de crédito a nível de passo.

Estabilizando o RL com Tree-GRPO: Eles refinam objetivos estilo PPO com valores q a nível de nó, normalização apenas da média e uma estratégia de clipping suave. Isso evita explosões de recompensa enquanto mantém os gradientes informativos.

Mantendo a Eficiência: Para cortar o desperdício de computação, o DeepSearch filtra para um subconjunto restrito de problemas, armazena soluções uma vez que são verificadas e pula a busca completa quando uma resposta já é conhecida.

Todas essas melhorias levam a resultados fortes.

O DeepSearch-1.5B alcança 62,95% nos benchmarks AIME/AMC, superando uma linha de base Nemotron de topo enquanto usa apenas ~330 horas de GPU. Em comparação, o treinamento normal de RL estagna mais baixo mesmo com mais de 1.800 horas de GPU.

Artigo:

Acho que este artigo oferece uma receita prática para superar platôs em LMs de raciocínio pequenos:

• Mover a busca para o treinamento, não apenas para a inferência

• Supervisionar tanto caminhos corretos quanto errados

• Usar priorização global para explorar de forma mais inteligente

• Armazenar em cache e filtrar para manter a eficiência alta

Top

Classificação

Favoritos