Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Cum antrenezi modele mici de raționament mai eficient?

Aceasta este o problemă cu care se confruntă mulți dezvoltatori AI. Reglarea fină a RL, în general, tinde să se stabilizeze, în special pentru modelele 1-2B.

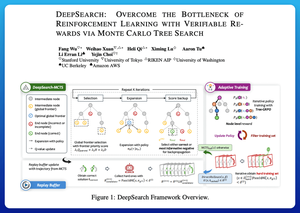

Cred că DeepSearch oferă o abordare foarte curată aici. Preia ideea Monte Carlo Tree Search (MCTS) la inferență și o mută în bucla de antrenament. Această schimbare deblochează o explorare mai bună și o învățare mai eficientă.

Iată notele mele din lucrare:

Bucla implică patru idei cheie:

Căutarea în timpul antrenamentului: În loc să se facă căutare doar în timpul testului, MCTS este rulat în timpul antrenamentului RL. Un selector UCT local clasifică frații, în timp ce un scorer de frontieră globală alege frunze promițătoare în întregul copac în funcție de valoarea părintelui, entropie și profunzime.

Dacă nu se găsește o soluție corectă, modelul învață în continuare prin supravegherea căii greșite încrezătoare (cele mai mici greșeli de entropie). Căile corecte rămân nenegative în timpul actualizărilor, ceea ce ajută la atribuirea creditelor la nivel de trepte.

Stabilizarea RL cu Tree-GRPO: Acestea rafinează obiectivele în stil PPO cu valori q la nivel de nod, normalizare doar a mediei și o strategie de tăiere ușoară. Acest lucru evită exploziile de recompensă, păstrând în același timp gradientele informative.

Rămâneți eficienți: Pentru a reduce calculul irosit, DeepSearch filtrează la un subset dificil de probleme, memorează în cache soluțiile odată ce sunt verificate și sare peste căutarea completă atunci când un răspuns este deja cunoscut.

Toate aceste îmbunătățiri duc la rezultate puternice.

DeepSearch-1.5B atinge 62,95% pe benchmark-urile AIME/AMC, depășind o bază de top Nemotron, folosind doar ~330 de ore GPU. Prin comparație, platourile normale de antrenament RL scad chiar și cu 1.800+ ore GPU.

Hârtie:

Cred că această lucrare oferă o rețetă practică pentru a sparge platourile în LM-uri cu raționament mic:

• Mutați căutarea în antrenament, nu doar în inferență

• Supravegheați atât căile corecte, cât și cele greșite

• Utilizați prioritizarea globală pentru a explora mai inteligent

• Cache și filtru pentru a menține eficiența ridicată

Limită superioară

Clasament

Favorite