Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Miten harjoittelet pieniä päättelymalleja tehokkaammin?

Tämä on ongelma, johon monet tekoälykehittäjät törmäävät. RL-hienosäädöllä on yleensä taipumus tasaantua, erityisesti 1–2B-malleissa.

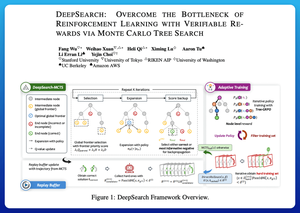

Mielestäni DeepSearch tarjoaa todella puhtaan lähestymistavan tähän. Se ottaa Monte Carlo Tree Searchin (MCTS) idean päättelyssä ja siirtää sen harjoitussilmukkaan. Tämä muutos avaa paremman tutkimisen ja tehokkaamman oppimisen.

Tässä ovat muistiinpanoni lehdestä:

Silmukka sisältää neljä keskeistä ajatusta:

Etsiminen koulutuksen aikana: Sen sijaan, että haku tehtäisiin vain testiaikana, MCTS suoritetaan RL-harjoittelun aikana. Paikallinen UCT-valitsija asettaa sisarukset paremmuusjärjestykseen, kun taas maailmanlaajuinen rajapisteiden tekijä poimii lupaavia lehtiä koko puusta emoarvon, entropian ja syvyyden perusteella.

Oppiminen sekä voitoista että itsevarmoista vääryyksistä: Jos oikeaa ratkaisua ei löydy, malli oppii silti valvomalla varmaa väärää polkua (alhaisimman entropian virheet). Oikeat polut pysyvät ei-negatiivisina päivitysten aikana, mikä auttaa vaihetason opintopisteiden määrittämisessä.

RL:n vakauttaminen Tree-GRPO:lla: Ne tarkentavat PPO-tyylisiä tavoitteita solmutason q-arvoilla, vain keskiarvon normalisoinnilla ja pehmeällä leikkausstrategialla. Näin vältytään palkitsemisräjähdyksiltä ja kaltevuudet pysyvät informatiivisina.

Tehokkuuden säilyttäminen: Hukkaan menevän laskennan vähentämiseksi DeepSearch suodattaa vaikean ongelmien osajoukon, tallentaa ratkaisut välimuistiin, kun ne on vahvistettu, ja ohittaa täyden haun, kun vastaus on jo tiedossa.

Kaikki nämä parannukset johtavat vahvoihin tuloksiin.

DeepSearch-1.5B saavuttaa 62.95 % AIME/AMC-vertailuarvoissa, mikä päihittää Nemotronin huippuperustason käyttämällä vain ~330 GPU-tuntia. Vertailun vuoksi normaali RL-harjoittelu laskee jopa 1 800+ GPU-tunnilla.

Paperi:

Mielestäni tämä artikkeli tarjoaa käytännöllisen reseptin tasankojen läpimurtamiseen pienissä päättelyissä:

• Siirrä haku koulutukseen, ei vain päättelyyn

• Valvo sekä oikeita että vääriä polkuja

• Käytä maailmanlaajuista priorisointia tutkiaksesi älykkäämmin

• Välimuisti ja suodatin pitävät tehokkuuden korkeana

Johtavat

Rankkaus

Suosikit