热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

如何更有效地训练小型推理模型?

这是许多AI开发者面临的问题。一般来说,强化学习微调往往会停滞不前,尤其是对于1–2B模型。

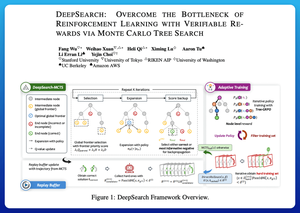

我认为DeepSearch在这里提供了一个非常清晰的方法。它将蒙特卡罗树搜索(MCTS)的理念在推理阶段引入训练循环。这一转变解锁了更好的探索和更高效的学习。

以下是我从论文中整理的笔记:

这个循环涉及四个关键思想:

训练期间搜索:在测试时仅进行搜索的情况下,MCTS在强化学习训练期间运行。一个局部UCT选择器对兄弟节点进行排名,而一个全局前沿评分器根据父节点的值、熵和深度选择有前景的叶子。

从胜利和自信的错误中学习:如果没有找到正确的解决方案,模型仍然通过监督自信的错误路径(最低熵的错误)进行学习。正确路径在更新期间保持非负,这有助于逐步信用分配。

通过树状GRPO稳定强化学习:他们通过节点级q值、仅均值归一化和软剪切策略来优化PPO风格的目标。这避免了奖励爆炸,同时保持梯度的信息性。

保持高效:为了减少浪费的计算,DeepSearch过滤出一个硬性问题子集,一旦解决方案得到验证就进行缓存,并在答案已知时跳过完整搜索。

所有这些改进都带来了强劲的结果。

DeepSearch-1.5B在AIME/AMC基准测试中达到了62.95%,超越了顶级Nemotron基线,同时仅使用了约330个GPU小时。相比之下,正常的强化学习训练即使使用1800多个GPU小时也会停滞在更低的水平。

论文:

我认为这篇论文提供了一个实用的配方,可以突破小型推理语言模型的停滞:

• 将搜索移入训练,而不仅仅是推理

• 监督正确和错误的路径

• 使用全局优先级进行更智能的探索

• 缓存和过滤以保持高效

热门

排行

收藏