Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Bagaimana Anda melatih model penalaran kecil dengan lebih efektif?

Ini adalah masalah yang dihadapi banyak pengembang AI. Penyetelan halus RL, secara umum, cenderung mendatar, terutama untuk model 1–2B.

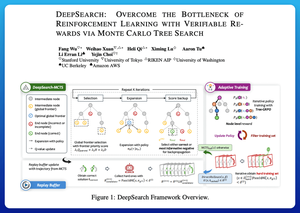

Saya pikir DeepSearch menawarkan pendekatan yang sangat bersih di sini. Dibutuhkan ide Monte Carlo Tree Search (MCTS) pada kesimpulan dan memindahkannya ke dalam lingkaran pelatihan. Pergeseran itu membuka eksplorasi yang lebih baik dan pembelajaran yang lebih efisien.

Berikut adalah catatan saya dari koran tersebut:

Loop melibatkan empat ide kunci:

Mencari Selama Pelatihan: Alih-alih hanya melakukan pencarian pada waktu pengujian, MCTS dijalankan selama pelatihan RL. Pemilih UCT lokal memberi peringkat saudara kandung, sementara pencetak gol perbatasan global memetik daun yang menjanjikan di seluruh pohon berdasarkan nilai induk, entropi, dan kedalaman.

Belajar dari Kemenangan dan Kesalahan Percaya Diri: Jika solusi yang benar tidak ditemukan, model masih belajar dengan mengawasi jalan yang salah yang percaya diri (kesalahan entropi terendah). Jalur yang benar tetap tidak negatif selama pembaruan, yang membantu penetapan kredit tingkat langkah.

Menstabilkan RL dengan Tree-GRPO: Mereka menyempurnakan tujuan gaya PPO dengan nilai q tingkat node, normalisasi rata-rata saja, dan strategi kliping lunak. Ini menghindari ledakan hadiah sambil menjaga gradien tetap informatif.

Tetap Efisien: Untuk mengurangi komputasi yang terbuang, DeepSearch memfilter ke subset masalah yang sulit, menyimpan solusi dalam cache setelah diverifikasi, dan melewatkan pencarian penuh saat jawabannya sudah diketahui.

Semua peningkatan ini menghasilkan hasil yang kuat.

DeepSearch-1.5B mencapai 62.95% pada tolok ukur AIME/AMC, mengalahkan baseline Nemotron teratas saat hanya menggunakan ~330 jam GPU. Sebagai perbandingan, pelatihan RL normal lebih rendah bahkan dengan 1.800+ jam GPU.

Kertas:

Saya pikir makalah ini menawarkan resep praktis untuk menerobos dataran tinggi dalam LM penalaran kecil:

• Pindahkan pencarian ke pelatihan, bukan hanya inferensi

• Mengawasi jalan yang benar dan salah

• Gunakan prioritas global untuk mengeksplorasi lebih cerdas

• Cache dan filter untuk menjaga efisiensi tetap tinggi

Teratas

Peringkat

Favorit