Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jak skuteczniej trenować małe modele rozumowania?

To problem, z którym boryka się wielu deweloperów AI. Dostosowywanie RL, w ogólności, ma tendencję do plateau, szczególnie w przypadku modeli 1–2B.

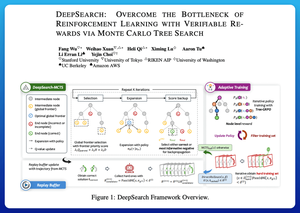

Myślę, że DeepSearch oferuje naprawdę czyste podejście w tej kwestii. Przenosi ideę Monte Carlo Tree Search (MCTS) z wnioskowania do pętli treningowej. Ta zmiana odblokowuje lepsze eksploracje i bardziej efektywne uczenie się.

Oto moje notatki z artykułu:

Pętla obejmuje cztery kluczowe pomysły:

Szukając podczas treningu: Zamiast tylko przeprowadzać wyszukiwanie w czasie testu, MCTS jest uruchamiane podczas treningu RL. Lokalny selektor UCT ocenia rodzeństwo, podczas gdy globalny oceniacz granicy wybiera obiecujące liście w całym drzewie na podstawie wartości rodzica, entropii i głębokości.

Uczenie się zarówno z wygranych, jak i pewnych błędów: Jeśli poprawne rozwiązanie nie zostanie znalezione, model nadal uczy się, nadzorując pewną błędną ścieżkę (najmniej entropijne błędy). Poprawne ścieżki pozostają nieujemne podczas aktualizacji, co pomaga w przypisywaniu zasług na poziomie kroków.

Stabilizacja RL z Tree-GRPO: Udoskonalają cele w stylu PPO z wartościami q na poziomie węzłów, normalizacją tylko średnią i strategią miękkiego przycinania. To unika eksplozji nagród, jednocześnie utrzymując gradienty informacyjne.

Zachowanie efektywności: Aby ograniczyć marnowanie obliczeń, DeepSearch filtruje do twardego podzbioru problemów, buforuje rozwiązania po ich weryfikacji i pomija pełne wyszukiwanie, gdy odpowiedź jest już znana.

Wszystkie te ulepszenia prowadzą do silnych wyników.

DeepSearch-1.5B osiąga 62,95% w benchmarkach AIME/AMC, bijąc najlepszą bazę Nemotron, używając tylko ~330 godzin GPU. Dla porównania, normalne treningi RL plateaują na niższym poziomie, nawet przy 1,800+ godzinach GPU.

Artykuł:

Myślę, że ten artykuł oferuje praktyczny przepis na przełamanie plateau w małych modelach rozumowania:

• Przenieś wyszukiwanie do treningu, a nie tylko do wnioskowania

• Nadzoruj zarówno poprawne, jak i błędne ścieżki

• Użyj globalnej priorytetyzacji, aby eksplorować mądrzej

• Buforuj i filtruj, aby utrzymać wysoką efektywność

Najlepsze

Ranking

Ulubione