Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hur tränar du små resonemangsmodeller mer effektivt?

Detta är ett problem som många AI-utvecklare stöter på. RL-finjustering tenderar i allmänhet att plana ut, särskilt för 1–2B-modeller.

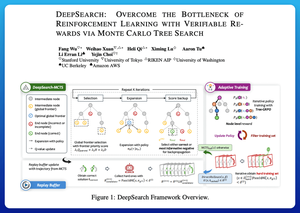

Jag tycker att DeepSearch erbjuder ett riktigt rent tillvägagångssätt här. Den tar idén om Monte Carlo Tree Search (MCTS) till slutsatsdragning och flyttar den till träningsloopen. Det skiftet öppnar upp för bättre utforskning och effektivare inlärning.

Här är mina anteckningar från tidningen:

Loopen omfattar fyra nyckelidéer:

Söka under träning: Istället för att bara göra sökning vid testtillfället körs MCTS under RL-träning. En lokal UCT-väljare rankar syskon, medan en global frontier-poängsättare plockar lovande löv över hela trädet baserat på föräldravärde, entropi och djup.

Att lära sig av både vinster och säkra fel: Om en korrekt lösning inte hittas lär sig modellen ändå genom att övervaka den säkra felaktiga vägen (lägsta entropifel). Korrekta sökvägar förblir icke-negativa under uppdateringar, vilket hjälper till med tilldelning av poäng på stegnivå.

Stabilisera RL med Tree-GRPO: De förfinar mål i PPO-stil med q-värden på nodnivå, normalisering av medelvärde och en mjuk klippningsstrategi. På så sätt undviker du belöningsexplosioner samtidigt som du håller gradienterna informativa.

Förbli effektiv: För att minska slöseri med beräkning filtrerar DeepSearch till en hård delmängd av problem, cachar lösningar när de har verifierats och hoppar över fullständig sökning när ett svar redan är känt.

Alla dessa förbättringar leder till starka resultat.

DeepSearch-1.5B når 62,95 % på AIME/AMC-benchmarks och slår en av Nemotrons bästa baslinjer samtidigt som den bara använder ~330 GPU-timmar. Som jämförelse sjunker normala RL-träningsplatåer även med 1 800+ GPU-timmar.

Papper:

Jag tror att den här uppsatsen erbjuder ett praktiskt recept för att bryta igenom platåer i små resonerande LM:er:

• Flytta sökning till träning, inte bara slutsatsdragning

• Övervaka både rätt och fel väg

• Använd global prioritering för att utforska smartare

• Cache och filter för att hålla effektiviteten hög

Topp

Rankning

Favoriter