Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Как более эффективно обучать небольшие модели рассуждений?

Это проблема, с которой сталкиваются многие разработчики ИИ. Тонкая настройка с использованием RL, как правило, достигает плато, особенно для моделей 1–2B.

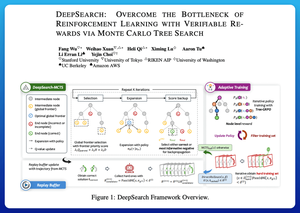

Я думаю, что DeepSearch предлагает действительно чистый подход. Он берет идею поиска Монте-Карло (MCTS) на этапе вывода и переносит ее в цикл обучения. Этот сдвиг открывает лучшие возможности для исследования и более эффективного обучения.

Вот мои заметки из статьи:

Цикл включает четыре ключевые идеи:

Поиск во время обучения: Вместо того чтобы проводить поиск только на этапе тестирования, MCTS выполняется во время обучения RL. Локальный селектор UCT ранжирует братьев и сестер, в то время как глобальный оценщик границы выбирает многообещающие листья по всему дереву на основе значения родителя, энтропии и глубины.

Обучение как на победах, так и на уверенных ошибках: Если правильное решение не найдено, модель все равно учится, контролируя уверенный неверный путь (ошибки с наименьшей энтропией). Правильные пути остаются неотрицательными во время обновлений, что помогает с распределением кредитов на уровне шагов.

Стабилизация RL с помощью Tree-GRPO: Они уточняют цели в стиле PPO с помощью значений q на уровне узлов, нормализации только по среднему и стратегии мягкого обрезания. Это предотвращает взрывы вознаграждений, сохраняя информативность градиентов.

Сохранение эффективности: Чтобы сократить ненужные вычисления, DeepSearch фильтрует до жесткого подмножества задач, кэширует решения после их проверки и пропускает полный поиск, когда ответ уже известен.

Все эти улучшения приводят к сильным результатам.

DeepSearch-1.5B достигает 62.95% на бенчмарках AIME/AMC, обгоняя топовую базу Nemotron, используя всего ~330 GPU-часов. Для сравнения, обычное обучение RL достигает более низкого плато даже с 1,800+ GPU-часами.

Статья:

Я думаю, что эта статья предлагает практический рецепт для преодоления плато в небольших моделях рассуждений:

• Перенести поиск в обучение, а не только в вывод

• Контролировать как правильные, так и неверные пути

• Использовать глобальную приоритизацию для более умного исследования

• Кэшировать и фильтровать, чтобы поддерживать высокую эффективность

Топ

Рейтинг

Избранное