トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

小さな推論モデルをより効果的にトレーニングするにはどうすればよいでしょうか?

これは、多くの AI 開発者が直面する問題です。一般に、RLの微調整は、特に1〜2Bモデルの場合、頭打ちになる傾向があります。

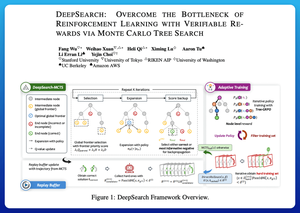

DeepSearchは、ここで非常にクリーンなアプローチを提供していると思います。推論時にモンテカルロツリー検索(MCTS)のアイデアを取り入れ、トレーニングループに移動します。この変化により、より良い探索とより効率的な学習が可能になります。

論文からの私のメモは次のとおりです。

このループには、次の 4 つの重要なアイデアが含まれます。

トレーニング中の検索: MCTS は、テスト時にのみ検索を実行するのではなく、RL トレーニング中に実行されます。ローカル UCT セレクターは兄弟をランク付けし、グローバル フロンティア スコアラーは、親の値、エントロピー、深さに基づいてツリー全体で有望な葉を選択します。

勝利と確信のある間違いの両方から学習する: 正しい解が見つからない場合でも、モデルは確信のある間違ったパス (最小エントロピーの間違い) を監視することで学習します。正しいパスは更新中も負のままであり、ステップレベルのクレジット割り当てに役立ちます。

Tree-GRPOによるRLの安定化:ノードレベルのq値、平均のみの正規化、およびソフトクリッピング戦略を使用して、PPOスタイルの目標を改良します。これにより、報酬の爆発を回避しながら、勾配を有益に保つことができます。

効率の維持: 無駄なコンピューティングを削減するために、DeepSearch は問題のハード サブセットにフィルタリングし、検証された解決策をキャッシュし、答えがすでにわかっている場合は完全な検索をスキップします。

これらの改善はすべて、強力な結果につながります。

DeepSearch-1.5B は AIME/AMC ベンチマークで 62.95% に達し、わずか ~330 GPU 時間しか使用せずに Nemotron のトップ ベースラインを上回りました。比較すると、通常のRLトレーニングは、1,800+ GPU時間でも低くなります。

紙:

この論文は、小さな推論LMで停滞期を突破するための実用的なレシピを提供すると思います。

• 検索を推論だけでなくトレーニングに移行

• 正しい道と間違った道の両方を監督する

• グローバル優先順位付けを使用して、よりスマートに探索する

• 効率を高く保つためのキャッシュとフィルター

トップ

ランキング

お気に入り