Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DailyHealthcareAI

Austausch von Forschungsarbeiten und Neuigkeiten zu KI-Anwendungen in der Radiologie, Pathologie, Genetik, Proteindesign und vielen mehr. Lassen Sie uns gemeinsam lernen!

🚀David Baker Preprint von @UWproteindesign 👇👇

Was macht das Schneiden von Proteinbindungen so herausfordernd, dass die Natur spezialisierte Enzyme mit Metallcofaktoren entwickelt hat, um dies zu erreichen?@biorxivpreprint @ETH_en

"Computational design of cysteine proteases"

• Amidbindungen in Proteinen haben Halbwertszeiten von Hunderten von Jahren unter physiologischen Bedingungen, was sie viel stabiler macht als Esterbindungen (mit Aminabgangsgruppen, die pKa >35 gegenüber <8 für aktivierte Ester haben), und das bisherige computergestützte Enzymdesign war nur mit aktivierten kleinen Molekülester-Substraten erfolgreich, anstatt mit dem energetisch anspruchsvollen Peptidbindungsschnitt, der für Proteasen erforderlich ist.

• Die Forscher verwendeten RoseTTAFold Diffusion 2 für Molekulare Schnittstellen (RFD2-MI), um Zinkproteasen aus minimalen katalytischen Motiven zu entwerfen, indem sie eine ideale aktive Stelle mit fünf funktionellen Gruppen (drei zinkbindende Reste H1, H2, E1, eine katalytische Base E2 und eine oxyanion-stabilisierende Tyrosin Y) basierend auf den Strukturen von Aminopeptidase N und Astacin konstruierten und ein zweiseitiges Design sowohl der Protease- als auch der Substratsequenzen durchführten, um die präzise Positionierung der Zielamidbindung sicherzustellen.

• Von 135 Designs, die in einer einzigen Entwurfsrunde getestet wurden, zeigten 36% Aktivität (14,7% für Zn-only Modelle und 87,5% für Zn-Wasser-Modelle), wobei alle aktiven Designs genau an den beabsichtigten Stellen schnitten, was durch Massenspektrometrie bestätigt wurde; das aktivste Design (Zn45 schneidet ZnO36 Substrat) erreichte kcat von 0,025 ± 0,002 s⁻¹, KM von 26 ± 5 μM und kcat/KM von 900 ± 200 M⁻¹s⁻¹, was eine >10⁸-fache Beschleunigung der Rate gegenüber der unkatalysierten Hydrolyse darstellt; die Designs zeigten Zinkbindung mit Kd zwischen 10⁻¹⁰ und 10⁻⁸ M, zeigten Substratspezifität in 4 von 5 Gerüsten und konnten umprogrammiert werden, um das krankheitsrelevante menschliche TDP-43-Protein mit 4 Varianten zu schneiden, die ≥80% Schnitt bei 5 Stunden erreichten.

Autoren: Hojae Choi et. al Donald Hilvert, Samuel J. Pellock, David Baker

Link:

608

Kann ein Sprachmodell die RNA-Struktur ohne explizite strukturelle Trainingsdaten lernen?@NatureComms @Tsinghua_Uni

"ERNIE-RNA: ein RNA-Sprachmodell mit strukturell verbesserten Repräsentationen"

• Bestehende RNA-Sprachmodelle übersehen strukturelle Informationen in Sequenzen, was zu unvollständiger Merkmalsextraktion und suboptimaler Leistung führt, trotz der hierarchischen Organisation von RNA, bei der primäre Sequenzen in spezifische strukturelle Konformationen gefaltet werden, die biologische Funktionen bestimmen. Traditionelle rechnergestützte Ansätze zur Vorhersage der RNA-Struktur stehen vor besonderen Herausforderungen: Thermodynamik-basierte Methoden sind durch die Genauigkeit der Parameter eingeschränkt, alignierungsbasierte Methoden haben Schwierigkeiten ohne ausreichende homologe Sequenzen, und Deep-Learning-Modelle zeigen eine begrenzte Generalisierbarkeit auf unbekannte RNA-Familien. Während BERT-ähnliche RNA-Sprachmodelle wie RNA-FM (trainiert auf 23 Millionen Sequenzen), UNI-RNA (1 Milliarde Sequenzen, 400M Parameter) und RiNALMo (36M Sequenzen, 650M Parameter) entstanden sind, versäumen sie es, strukturelle Informationen angemessen zu integrieren, wobei einige wie UTR-LM versuchen, dies zu adressieren, indem sie vorhergesagte Strukturen von RNAfold einbeziehen, jedoch Einschränkungen durch Vorhersagefehler und reduzierte Generalisierbarkeit haben.

• ERNIE-RNA ist ein RNA-vortrainiertes Sprachmodell mit 86 Millionen Parametern, das auf einer modifizierten BERT-Architektur mit 12 Transformatorblöcken und 12 Aufmerksamkeitsköpfen basiert, trainiert auf 20,4 Millionen nicht-kodierenden RNA-Sequenzen von RNAcentral, nachdem Sequenzen länger als 1022 Nukleotide gefiltert und eine CD-HIT-Redundanzentfernung bei 100% Ähnlichkeit angewendet wurde. Das Modell integriert einen auf Basenpaarung basierenden Aufmerksamkeitsbias-Mechanismus, der Werte von 2 für AU-Paare, 3 für CG-Paare und einen einstellbaren Parameter α (anfänglich 0,8) für GU-Paare in einer All-gegen-Alle-Paarweise-Positionsmatrix zuweist, wobei der Bias-Term in der ersten Transformator-Schicht ersetzt wird. Das Vortraining verwendete maskiertes Sprachmodellieren mit 15% der Tokens, die zufällig ersetzt wurden, trainiert über 20 Tage auf 24 32G-V100 GPUs mit fairseq bei einer Basis-Lernrate von 0,0001, 20.000 Aufwärmschritten und 0,01 Gewichtszunahme, wobei sowohl Aufmerksamkeitskarten (L×L×156) als auch Token-Embeddings (12×768×L) als Ausgaben generiert wurden.

• Die Aufmerksamkeitskarten von ERNIE-RNA zeigten die Fähigkeit zur Null-Schuss-Vorhersage der RNA-Sekundärstruktur mit einem medianen F1-Score von 0,552 im bpRNA-1m-Testset und übertrafen RNAfold (0,492), RNAstructure (0,491), RNAErnie (0,440) und RNA-BERT (0,365) ohne Feinabstimmung. Nach der Feinabstimmung erreichte ERNIE-RNA einen Stand der Technik mit makro- Durchschnitts-F1-Scores von 0,873 im bpRNA-1m, übertraf RiNALMo (0,850, 650M Parameter) und UNI-RNA (0,821, 400M Parameter) und zeigte ähnliche Führungspositionen bei ArchiveII (0,954 gegenüber RiNALMos 0,892) und RIVAS TestSetB (0,721 gegenüber RiNALMos 0,555). Bei herausfordernden Generalisierungstests über Familien hinweg erzielte ERNIE-RNA gefroren F1-Scores von 0,646 im bpRNA-new und 0,590 im RNA3DB-2D, übertraf traditionelle dynamische Programmiermethoden wie Eternafold (0,639) und behielt die Überlegenheit über alle Deep-Learning-Wettbewerber. ERNIE-RNA erzielte auch überlegene Leistungen in verschiedenen nachgelagerten Aufgaben: Vorhersage von RNA-Kontaktkarten mit einer Top-L/1-Präzision von 0,68 (gegenüber dem Ensemble von RNAcontact mit 0,46), Vorhersage von 5'UTR MRL mit R² von 0,92 im zufälligen Testset und 0,86 im menschlichen Testset, RNA-Protein-Bindungsvorhersage, die alle getesteten Methoden übertraf, Klassifizierungsgenauigkeiten von ncRNA-Familien von 0,9844 (0% Grenzrauschen) und 0,9820 (200% Grenzrauschen), F1-Scores für die Vorhersage von Spleißstellen, die von 0,9180 bis 0,9612 über vier Arten reichten, Top-K-Genauigkeit von 55,37% im SpliceAI-Datensatz (gegenüber 34,84% von RNA-FM) und Vorhersage von alternativer Polyadenylierung mit R² von 78,39% (gegenüber 70,32% von RNA-FM).

Autoren: Weijie Yin, Zhaoyu Zhang, Shuo Zhang, Liang He et. al Xuegong Zhang, Tao Qin & Zhen Xie

Link:

633

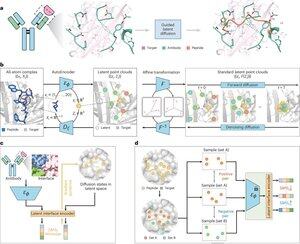

Kann künstliche Intelligenz therapeutische Peptide entwerfen, indem sie imitiert, wie natürliche Proteine an Krankheitsziele binden?@Tsinghua_Uni @natBME

"Peptidentwurf durch Nachahmung von Bindungsoberflächen mit PepMimic"

• Forscher entwickelten PepMimic, einen KI-Algorithmus, der einen All-Atom-Autoencoder, ein latentes Diffusionsmodell und einen Schnittstellen-Encoder kombiniert, um Peptide (4-25 Aminosäuren) zu entwerfen, die Bindungsoberflächen zwischen Zielproteinen und bekannten Bindern wie Antikörpern oder Rezeptoren nachahmen, um die Einschränkungen im aktuellen Peptidentwurf zu adressieren, der manuelle Expertise erfordert und Schwierigkeiten mit diskontinuierlichen Bindungsoberflächen hat.

• Über 80 peptide therapeutics sind für Krankheiten wie Diabetes und Krebs zugelassen, bieten Vorteile wie hohe Spezifität, geringere Toxizität und potenzielle orale Verabreichung im Vergleich zu kleinen Molekülen und Biologika, doch der Entwurf von Peptidmimetika für Protein-Protein-Interaktionen erfordert traditionell umfangreiche Expertise und kann diskontinuierliche Bindungsoberflächen nicht effektiv handhaben, während bestehende KI-Modelle sich auf Backbone-then-Sequence-Ansätze konzentrieren, anstatt die entscheidende Seitenkettengeometrie für genaue Aminosäureinteraktionen zu erfassen.

• PepMimic wurde auf 4.157 Protein-Peptid-Komplexen und 70.645 peptidähnlichen Fragmenten aus der Protein-Datenbank trainiert, wobei ein Autoencoder verwendet wurde, um All-Atom-Geometrien in latente Räume zu überführen, ein Diffusionsmodell für 100 Entrauschungsschritte und kontrastives Lernen, um einen Schnittstellen-Encoder zu trainieren, der die Generierung leitet, indem er die Abstände zwischen entworfenen und Referenzschnittstellen im latenten Raum minimiert, wobei die Kandidaten mit Rosetta-Schnittstellenenergie, FoldX-Energie, Schnittstellen-Hit-Metriken und AlphaFold-Multimer-pLDDT-Werten bewertet wurden, bevor die besten Peptide (384 für Ziele mit bekannten Bindern, 94-290 für KI-generierte Binder) für Oberflächenplasmonenresonanz-Imaging-Experimente ausgewählt wurden.

• PepMimic erreichte einen durchschnittlichen AUROC von 0,71 über 31 Aufgaben bei 93 Testkomplexen (übertraf RFDiffusion mit 0,69), entwarf 384 Peptide für 5 Arzneimittelziele (PD-L1, CD38, BCMA, HER2, CD4), wobei 8% KD < 100 nM erreichten und 26 Peptide KD auf dem Niveau von 10⁻⁹ M erreichten (deutlich höher als bei der zufälligen Bibliotheks-Screening), generierte Peptide, die AI-gestaltete Binder für CD38 und TROP2 nachahmten, mit einer Erfolgsquote von 14% (16% für CD38, 8% für TROP2), und zeigte eine effektive in vivo Tumoransprache in Mausmodellen, wobei ausgewählte Peptide eine 8,85-fache höhere Aufnahme in PD-L1-positiven Tumoren und eine 16,18-fache höhere Aufnahme in TROP2-positiven Tumoren zeigten, mit Erfolgsquoten, die 20.000-90.000 Mal höher waren als bei experimentellen zufälligen Bibliotheks-Screenings.

Autoren: Xiangzhe Kong et. al Zihua Wang, Yang Liu & @musicsuperman

Link:

1,24K

Top

Ranking

Favoriten