Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DailyHealthcareAI

Dela forskningsrapporter och nyheter om AI-tillämpningar inom radiologi, patologi, genetik, proteindesign och många fler. Låt oss lära oss tillsammans!

🚀David Bakers förtryck från @UWproteindesign 👇👇

Vad gör det så svårt att skära proteinbindningar att naturen utvecklat specialiserade enzymer med metallkofaktorer för att åstadkomma det?@biorxivpreprint @ETH_en

"Beräkningsdesign av cysteinproteaser"

• Amidbindningar i proteiner har halveringstider på hundratals år under fysiologiska förhållanden, vilket gör dem mycket mer stabila än esterbindningar (där aminlämnande grupper har pKa >35 jämfört med <8 för aktiverade ester), och tidigare beräkningsmässig enzymdesign har endast lyckats med aktiverade småmolekylära estersubstrat snarare än den energikrävande peptidbindningsklyvning som krävs för proteaser.

• Forskarna använde RoseTTAFold Diffusion 2 for Molecular Interfaces (RFD2-MI) för att designa zinkproteaser från minimala katalytiska motiv, och konstruerade en idealisk aktiv plats med fem funktionella grupper (tre zinkbindande rester H1, H2, E1, en katalytisk bas E2 och en oxyanionstabiliserande tyrosin Y) baserat på aminopeptidas N- och astacinstrukturer, och utförde en tvåsidig design av både proteas- och substratsekvenser för att säkerställa exakt positionering av målamidbindningen.

• Av 135 designer som testades i en enda designrunda visade 36 % aktivitet (14,7 % för enbart zinkmodeller och 87,5 % för zinkvattenmodeller), där alla aktiva designer klöv exakt på avsedda platser bekräftade med masspektrometri; den mest aktiva designen (Zn45-klyvande ZnO36-substrat) uppnådde kcat på 0,025 ± 0,002 s⁻¹, KM på 26 ± 5 μM och kcat/KM på 900 ± 200 M⁻¹s⁻¹, vilket representerar >10⁸-faldig acceleration över okatalyserad hydrolys; designer visade zinkbindning med Kd mellan 10⁻¹⁰ och 10⁻⁸ M, visade substratspecificitet i 4 av 5 ställningar och kunde omprogrammeras för att klyva sjukdomsrelevant mänskligt TDP-43-protein med 4 varianter som uppnådde ≥80 % klyvning efter 5 timmar.

Författare: Hojae Choi m.fl. al Donald Hilvert, Samuel J. Pellock, David Baker

Länk:

613

Kan en språkmodell lära sig RNA-struktur utan explicit strukturell träningsdata?@NatureComms @Tsinghua_Uni

"ERNIE-RNA: en RNA-språkmodell med strukturförstärkta representationer"

• Befintliga RNA-språkmodeller förbiser strukturell information i sekvenser, vilket leder till ofullständig funktionsextraktion och suboptimal prestanda, trots RNA:s hierarkiska organisation där primära sekvenser viks in i specifika strukturella konformationer som bestämmer biologiska funktioner. Traditionella beräkningsmetoder för RNA-strukturprediktion står inför särskilda utmaningar: termodynamikbaserade metoder begränsas av parameternoggrannhet, justeringsbaserade metoder har svårt utan tillräckligt homologa sekvenser, och djupinlärningsmodeller visar begränsad generalisering till osedda RNA-familjer. Även om BERT-liknande RNA-språkmodeller som RNA-FM (tränad på 23 miljoner sekvenser), UNI-RNA (1 miljard sekvenser, 400M parametrar) och RiNALMo (36M sekvenser, 650M parametrar) har dykt upp, misslyckas de med att tillräckligt integrera strukturell information, och vissa som UTR-LM försöker åtgärda detta genom att införliva förutsagda strukturer från RNAfold men möter begränsningar på grund av förutsägelsefel och minskad generaliseringsförmåga.

• ERNIE-RNA är en 86 miljoner parametrar RNA-förtränad språkmodell baserad på modifierad BERT-arkitektur med 12 transformatorblock och 12 uppmärksamhetshuvuden, tränad på 20,4 miljoner icke-kodande RNA-sekvenser från RNAcentral efter filtrering av sekvenser längre än 1022 nukleotider och tillämpning av CD-HIT-redundansborttagning vid 100 % likhet. Modellen innehåller en basparningsbaserad uppmärksamhetsbias-mekanism som tilldelar värdena 2 för AU-par, 3 för CG-par och en justerbar parameter α (initialt 0,8) för GU-par i en all-mot-alla-parvis positionsmatris, som ersätter biastermen i det första transformatorlagret. Förträningen använde maskerad språkmodellering där 15 % av tokens slumpmässigt byttes ut, tränades i 20 dagar på 24 32G-V100 GPU:er med fairseq och basinlärningshastighet 0,0001, 20 000 uppvärmningssteg och 0,01 viktminskning, vilket genererade både attention maps (L×L×156) och token embeddings (12×768×L) som utdata.

• ERNIE-RNA:s attention maps visade zero-shot RNA:s sekundärstrukturprediktion med en median F1-score på 0,552 på bpRNA-1m-testset, vilket överträffade RNAfold (0,492), RNAstruktur (0,491), RNAErnie (0,440) och RNA-BERT (0,365) utan finjustering. Efter finjustering uppnådde ERNIE-RNA toppmoderna makrogenomsnittliga F1-poäng på 0,873 på bpRNA-1m, vilket överträffade RiNALMo (0,850, 650M parametrar) och UNI-RNA (0,821, 400M parametrar), med liknande ledarskap på ArchiveII (0,954 mot RiNALMos 0,892) och RIVAS TestSetB (0,721 mot RiNALMos 0,555). På utmanande cross-family generalization-tester uppnådde ERNIE-RNA fryst F1-poäng på 0,646 på bpRNA-new och 0,590 på RNA3DB-2D, vilket överträffade traditionella dynamiska programmeringsmetoder som Eternafold (0,639) och behöll överlägsenhet gentemot alla konkurrenter inom djupinlärning. ERNIE-RNA uppnådde också överlägsen prestanda inom olika nedströmsuppgifter: RNA-kontaktkartprediktion med Top-L/1-precision på 0,68 (jämfört med RNAcontacts ensemble på 0,46), 5'UTR MRL-prediktion med R² på 0,92 på slumpmässiga testset och 0,86 på mänskliga tester, RNA-proteinbindningsprediktion som överträffade alla testade metoder, ncRNA-familjens klassificeringsnoggrannheter på 0,9844 (0 % gränsbrus) och 0,9820 (200 % gränsbrus), Splice Site prediction F1-poäng från 0,9180 till 0,9612 över fyra arter, topp-K noggrannhet på 55,37 % på SpliceAI-dataset (jämfört med RNA-FM:s 34,84 %) och alternativ polyadenyleringsprediktion R² på 78,39 % (jämfört med RNA-FM:s 70,32 %).

Författare: Weijie Yin, Zhaoyu Zhang, Shuo Zhang, Liang He med flera. al Xuegong Zhang, Tao Qin & Zhen Xie

Länk:

638

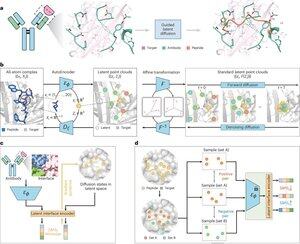

Kan artificiell intelligens designa terapeutiska peptider genom att efterlikna hur naturliga proteiner binder till sjukdomsmål?@Tsinghua_Uni @natBME

"Peptiddesign genom imitation av bindningsgränssnitt med PepMimic"

• Forskare utvecklade PepMimic, en AI-algoritm som kombinerar en autokodare med alla atomer, en latent diffusionsmodell och en gränssnittskodare för att designa peptider (4-25 aminosyror) som efterliknar bindningsgränssnitt mellan målproteiner och kända bindemedel som antikroppar eller receptorer, vilket tar itu med begränsningar i nuvarande peptiddesign som kräver manuell expertis och kämpar med diskontinuerliga bindningsytor.

• Över 80 peptidterapier är godkända för sjukdomar inklusive diabetes och cancer, och erbjuder fördelar som hög specificitet, lägre toxicitet och potentiell oral administrering jämfört med små molekyler och biologiska läkemedel, men att designa peptidimitationer av protein-proteininteraktioner kräver traditionellt omfattande expertis och kan inte effektivt hantera diskontinuerliga bindningsgränssnitt, medan befintliga AI-modeller fokuserar på ryggrads-sedan-sekvens-metoder snarare än att fånga avgörande sidokedja Geometri för exakta aminosyrainteraktioner.

PepMimic tränades på 4 157 protein-peptidkomplex och 70 645 peptidliknande fragment från Protein Data Bank, med hjälp av en autokodare för att kartlägga alla atomgeometrier till latent rymd, en diffusionsmodell för 100 denoisingsteg, och kontrastiv inlärning för att träna en gränssnittskodare som vägleder generering genom att minimera avstånd mellan designade och referensgränssnitt i latent rymd, med kandidater rankade med hjälp av Rosetta-gränssnittsenergi, FoldX-energi, mätvärden för gränsyteträffar och AlphaFold Multimer pLDDT poäng innan du väljer topppeptider (384 för mål med kända bindare, 94-290 för AI-genererade bindare) för ytplasmonresonanstomografiexperiment.

• PepMimic uppnådde en genomsnittlig AUROC på 0,71 över 31 uppgifter på 93 testkomplex (vilket överträffade RFDiffusions 0,69), designade 384 peptider för 5 läkemedelsmål (PD-L1, CD38, BCMA, HER2, CD4) där 8 % uppnådde KD < 100 nM och 26 peptider nådde KD vid 10⁻⁹ M-nivå (betydligt högre än slumpmässig biblioteksscreening), genererade peptider som efterliknar AI-designade bindemedel för CD38 och TROP2 med 14 % framgångsfrekvens (16 % för CD38, 8 % för TROP2), och visade sig vara effektiv in vivo riktad mot tumörer i musmodeller med utvalda peptider som visade 8,85 gånger större upptag i PD-L1-positiva tumörer och 16,18 gånger större upptag i TROP2-positiva tumörer, vilket uppnådde framgångsfrekvenser som var 20 000-90 000 gånger högre än experimentell slumpmässig biblioteksscreening.

Författare: Xiangzhe Kong et. al Zihua Wang, Yang Liu och @musicsuperman

Länk:

1,25K

Topp

Rankning

Favoriter