Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DailyHealthcareAI

Partager des articles de recherche et des nouvelles sur les applications de l’IA en radiologie, en pathologie, en génétique, en conception de protéines et bien d’autres. Apprenons ensemble !

🚀David Baker prépublication de @UWproteindesign 👇👇

Qu'est-ce qui rend la coupure des liaisons protéiques si difficile que la nature a évolué des enzymes spécialisées avec des cofacteurs métalliques pour y parvenir ?@biorxivpreprint @ETH_en

"Conception computationnelle des cystéine protéases"

• Les liaisons amides dans les protéines ont des demi-vies de centaines d'années dans des conditions physiologiques, les rendant beaucoup plus stables que les liaisons ester (avec des groupes sortants amine ayant un pKa >35 contre <8 pour les esters activés), et la conception d'enzymes computationnelles précédente n'a réussi qu'avec des substrats esters de petites molécules activées plutôt qu'avec la coupure de liaisons peptidiques énergétiquement exigeante requise pour les protéases.

• Les chercheurs ont utilisé RoseTTAFold Diffusion 2 pour les Interfaces Moléculaires (RFD2-MI) pour concevoir des protéases au zinc à partir de motifs catalytiques minimaux, construisant un site actif idéal avec cinq groupes fonctionnels (trois résidus de liaison au zinc H1, H2, E1, une base catalytique E2, et une tyrosine Y stabilisant l'oxyanion) basé sur les structures de l'aminopeptidase N et de l'astacine, effectuant une conception bilatérale des séquences de protéase et de substrat pour garantir un positionnement précis de la liaison amide cible.

• Sur 135 conceptions testées dans un seul tour de conception, 36 % ont montré une activité (14,7 % pour les modèles uniquement au Zn et 87,5 % pour les modèles Zn-eau), toutes les conceptions actives clivant précisément aux sites prévus confirmés par spectrométrie de masse ; la conception la plus active (Zn45 clivant le substrat ZnO36) a atteint un kcat de 0,025 ± 0,002 s⁻¹, un KM de 26 ± 5 μM, et un kcat/KM de 900 ± 200 M⁻¹s⁻¹, représentant un accroissement de taux >10⁸ fois par rapport à l'hydrolyse non catalysée ; les conceptions ont montré une liaison au zinc avec un Kd entre 10⁻¹⁰ et 10⁻⁸ M, ont montré une spécificité de substrat dans 4 des 5 échafaudages, et pouvaient être reprogrammées pour cliver la protéine humaine TDP-43 pertinente pour les maladies avec 4 variantes atteignant ≥80 % de clivage en 5 heures.

Auteurs : Hojae Choi et al. Donald Hilvert, Samuel J. Pellock, David Baker

Lien :

614

Un modèle de langage peut-il apprendre la structure de l'ARN sans données d'entraînement structurelles explicites ?@NatureComms @Tsinghua_Uni

"ERNIE-RNA : un modèle de langage ARN avec des représentations améliorées par la structure"

• Les modèles de langage ARN existants négligent les informations structurelles dans les séquences, ce qui conduit à une extraction de caractéristiques incomplète et à des performances sous-optimales, malgré l'organisation hiérarchique de l'ARN où les séquences primaires se replient en conformations structurelles spécifiques qui déterminent les fonctions biologiques. Les approches computationnelles traditionnelles pour la prédiction de la structure de l'ARN rencontrent des défis distincts : les méthodes basées sur la thermodynamique sont contraintes par l'exactitude des paramètres, les méthodes basées sur l'alignement peinent sans séquences homologues suffisantes, et les modèles d'apprentissage profond montrent une généralisation limitée aux familles d'ARN non vues. Bien que des modèles de langage ARN de type BERT comme RNA-FM (entraîné sur 23 millions de séquences), UNI-RNA (1 milliard de séquences, 400M de paramètres) et RiNALMo (36M de séquences, 650M de paramètres) aient émergé, ils échouent à incorporer adéquatement les informations structurelles, certains comme UTR-LM tentant de remédier à cela en intégrant des structures prédites de RNAfold mais faisant face à des limitations dues aux erreurs de prédiction et à une capacité de généralisation réduite.

• ERNIE-RNA est un modèle de langage ARN pré-entraîné de 86 millions de paramètres basé sur une architecture BERT modifiée avec 12 blocs de transformateurs et 12 têtes d'attention, entraîné sur 20,4 millions de séquences d'ARN non codantes provenant de RNAcentral après filtrage des séquences de plus de 1022 nucléotides et application d'une suppression de redondance CD-HIT à 100 % de similarité. Le modèle intègre un mécanisme de biais d'attention informé par les paires de bases qui attribue des valeurs de 2 pour les paires AU, 3 pour les paires CG, et un paramètre ajustable α (initialement 0,8) pour les paires GU dans une matrice de position pair-à-pair, remplaçant le terme de biais dans la première couche de transformateur. L'entraînement préliminaire a utilisé un modèle de langage masqué avec 15 % des tokens remplacés aléatoirement, entraîné pendant 20 jours sur 24 GPU 32G-V100 utilisant fairseq avec un taux d'apprentissage de base de 0,0001, 20 000 étapes de réchauffement et une décroissance de poids de 0,01, générant à la fois des cartes d'attention (L×L×156) et des embeddings de tokens (12×768×L) en sortie.

• Les cartes d'attention d'ERNIE-RNA ont démontré une capacité de prédiction de la structure secondaire de l'ARN en zéro-shot avec un score F1 médian de 0,552 sur le jeu de test bpRNA-1m, surpassant RNAfold (0,492), RNAstructure (0,491), RNAErnie (0,440) et RNA-BERT (0,365) sans ajustement. Après ajustement, ERNIE-RNA a atteint des scores F1 macro-moyens à la pointe de 0,873 sur bpRNA-1m, surpassant RiNALMo (0,850, 650M de paramètres) et UNI-RNA (0,821, 400M de paramètres), avec un leadership similaire sur ArchiveII (0,954 contre 0,892 de RiNALMo) et RIVAS TestSetB (0,721 contre 0,555 de RiNALMo). Lors de tests de généralisation inter-familles difficiles, ERNIE-RNA gelé a atteint des scores F1 de 0,646 sur bpRNA-new et 0,590 sur RNA3DB-2D, surpassant les méthodes traditionnelles de programmation dynamique comme Eternafold (0,639) et maintenant sa supériorité sur tous les concurrents d'apprentissage profond. ERNIE-RNA a également obtenu des performances supérieures dans diverses tâches en aval : prédiction de carte de contact ARN avec une précision Top-L/1 de 0,68 (contre l'ensemble de RNAcontact à 0,46), prédiction MRL 5'UTR avec R² de 0,92 sur un jeu de test aléatoire et 0,86 sur un jeu de test humain, prédiction de liaison ARN-protéine surpassant toutes les méthodes testées, précisions de classification de famille ncRNA de 0,9844 (0 % de bruit de frontière) et 0,9820 (200 % de bruit de frontière), scores F1 de prédiction de site d'épissage variant de 0,9180 à 0,9612 à travers quatre espèces, précision top-K de 55,37 % sur le jeu de données SpliceAI (contre 34,84 % de RNA-FM), et prédiction de polyadénylation alternative R² de 78,39 % (contre 70,32 % de RNA-FM).

Auteurs : Weijie Yin, Zhaoyu Zhang, Shuo Zhang, Liang He et al. Xuegong Zhang, Tao Qin & Zhen Xie

Lien :

639

L'intelligence artificielle peut-elle concevoir des peptides thérapeutiques en imitant la façon dont les protéines naturelles se lient aux cibles de maladies ?@Tsinghua_Uni @natBME

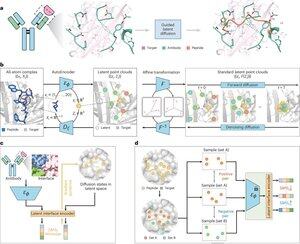

"Conception de peptides par imitation des interfaces de liaison avec PepMimic"

• Les chercheurs ont développé PepMimic, un algorithme d'IA combinant un autoencodeur à atomes complets, un modèle de diffusion latent et un encodeur d'interface pour concevoir des peptides (4-25 acides aminés) qui imitent les interfaces de liaison entre les protéines cibles et les ligands connus comme les anticorps ou les récepteurs, répondant aux limitations de la conception actuelle de peptides qui nécessite une expertise manuelle et peine à gérer les surfaces de liaison discontinues.

• Plus de 80 thérapeutiques peptidiques sont approuvées pour des maladies telles que le diabète et le cancer, offrant des avantages comme une spécificité élevée, une toxicité réduite et une administration potentielle par voie orale par rapport aux petites molécules et aux biologiques, cependant, la conception de mimétiques peptidiques d'interactions protéine-protéine nécessite traditionnellement une expertise approfondie et ne peut pas gérer efficacement les interfaces de liaison discontinues, tandis que les modèles d'IA existants se concentrent sur des approches de squelette puis de séquence plutôt que de capturer la géométrie cruciale des chaînes latérales pour des interactions précises entre acides aminés.

• PepMimic a été entraîné sur 4 157 complexes protéine-peptide et 70 645 fragments de type peptide provenant de la Protein Data Bank, utilisant un autoencodeur pour mapper les géométries à atomes complets dans un espace latent, un modèle de diffusion pour 100 étapes de débruitage, et un apprentissage contrastif pour entraîner un encodeur d'interface qui guide la génération en minimisant les distances entre les interfaces conçues et de référence dans l'espace latent, avec des candidats classés en utilisant l'énergie d'interface Rosetta, l'énergie FoldX, les métriques d'interface et les scores pLDDT d'AlphaFold Multimer avant de sélectionner les meilleurs peptides (384 pour les cibles avec des ligands connus, 94-290 pour les ligands générés par IA) pour des expériences d'imagerie par résonance plasmonique de surface.

• PepMimic a atteint une AUROC moyenne de 0,71 sur 31 tâches sur 93 complexes de test (dépassant les 0,69 de RFDiffusion), a conçu 384 peptides pour 5 cibles médicamenteuses (PD-L1, CD38, BCMA, HER2, CD4) avec 8 % atteignant un KD < 100 nM et 26 peptides atteignant un KD au niveau de 10⁻⁹ M (substantiellement plus élevé que le criblage de bibliothèque aléatoire), a généré des peptides imitant des ligands conçus par IA pour CD38 et TROP2 avec un taux de succès de 14 % (16 % pour CD38, 8 % pour TROP2), et a démontré un ciblage tumoral in vivo efficace dans des modèles murins avec des peptides sélectionnés montrant une absorption 8,85 fois plus élevée dans des tumeurs positives pour PD-L1 et 16,18 fois plus élevée dans des tumeurs positives pour TROP2, atteignant des taux de succès 20 000 à 90 000 fois plus élevés que le criblage de bibliothèque aléatoire expérimental.

Auteurs : Xiangzhe Kong et al. Zihua Wang, Yang Liu & @musicsuperman

Lien :

1,25K

Meilleurs

Classement

Favoris