Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DailyHealthcareAI

Condivisione di documenti di ricerca e notizie sulle applicazioni dell'intelligenza artificiale in radiologia, patologia, genetica, progettazione di proteine e molto altro. Impariamo insieme!

🚀David Baker preprint da @UWproteindesign 👇👇

Cosa rende così difficile il taglio dei legami proteici al punto che la natura ha evoluto enzimi specializzati con cofattori metallici per realizzarlo?@biorxivpreprint @ETH_en

"Progettazione computazionale delle cisteina proteasi"

• I legami ammidici nelle proteine hanno emivite di centinaia di anni in condizioni fisiologiche, rendendoli molto più stabili rispetto ai legami esterei (con gruppi uscenti amminici aventi pKa >35 contro <8 per gli esteri attivati), e la precedente progettazione computazionale degli enzimi ha avuto successo solo con substrati esteri di piccole molecole attivate piuttosto che con la scissione energeticamente impegnativa dei legami peptidici richiesta per le proteasi.

• I ricercatori hanno utilizzato RoseTTAFold Diffusion 2 per Interfacce Molecolari (RFD2-MI) per progettare proteasi di zinco a partire da motivi catalitici minimi, costruendo un sito attivo ideale con cinque gruppi funzionali (tre residui di legame allo zinco H1, H2, E1, una base catalitica E2 e una tirosina Y stabilizzante dell'ossianione) basato sulle strutture dell'aminopeptidasi N e dell'astacina, eseguendo una progettazione bilaterale sia delle sequenze di proteasi che di substrato per garantire il posizionamento preciso del legame ammidico target.

• Di 135 progetti testati in un singolo turno di progettazione, il 36% ha mostrato attività (14.7% per i modelli solo di Zn e 87.5% per i modelli Zn-acqua), con tutti i progetti attivi che scindono precisamente nei siti previsti confermati dalla spettrometria di massa; il progetto più attivo (Zn45 che scinde il substrato ZnO36) ha raggiunto un kcat di 0.025 ± 0.002 s⁻¹, KM di 26 ± 5 μM, e kcat/KM di 900 ± 200 M⁻¹s⁻¹, rappresentando un'accelerazione del tasso >10⁸ volte rispetto all'idrolisi non catalizzata; i progetti hanno mostrato legame con lo zinco con Kd tra 10⁻¹⁰ e 10⁻⁸ M, hanno mostrato specificità per il substrato in 4 dei 5 scaffali, e potrebbero essere riprogrammati per scindere la proteina umana TDP-43 rilevante per le malattie con 4 varianti che raggiungono ≥80% di scissione a 5 ore.

Autori: Hojae Choi et. al Donald Hilvert, Samuel J. Pellock, David Baker

Link:

609

Un modello linguistico può apprendere la struttura dell'RNA senza dati di addestramento strutturali espliciti?@NatureComms @Tsinghua_Uni

"ERNIE-RNA: un modello linguistico RNA con rappresentazioni potenziate dalla struttura"

• I modelli linguistici RNA esistenti trascurano le informazioni strutturali nelle sequenze, portando a un'estrazione incompleta delle caratteristiche e a prestazioni subottimali, nonostante l'organizzazione gerarchica dell'RNA in cui le sequenze primarie si piegano in conformazioni strutturali specifiche che determinano le funzioni biologiche. Gli approcci computazionali tradizionali per la previsione della struttura dell'RNA affrontano sfide distinte: i metodi basati sulla termodinamica sono vincolati dall'accuratezza dei parametri, i metodi basati sull'allineamento faticano senza sequenze omologhe sufficienti e i modelli di deep learning mostrano una generalizzazione limitata a famiglie di RNA non viste. Mentre i modelli linguistici RNA in stile BERT come RNA-FM (addestrato su 23 milioni di sequenze), UNI-RNA (1 miliardo di sequenze, 400M parametri) e RiNALMo (36M sequenze, 650M parametri) sono emersi, non riescono a incorporare adeguatamente le informazioni strutturali, con alcuni come UTR-LM che tentano di affrontare questo problema incorporando strutture previste da RNAfold ma affrontando limitazioni dovute a errori di previsione e ridotta capacità di generalizzazione.

• ERNIE-RNA è un modello linguistico RNA pre-addestrato con 86 milioni di parametri basato su un'architettura BERT modificata con 12 blocchi di trasformatori e 12 teste di attenzione, addestrato su 20,4 milioni di sequenze di RNA non codificante da RNAcentral dopo aver filtrato le sequenze più lunghe di 1022 nucleotidi e applicato la rimozione della ridondanza CD-HIT al 100% di somiglianza. Il modello incorpora un meccanismo di bias di attenzione informato dal pairing di basi che assegna valori di 2 per le coppie AU, 3 per le coppie CG e un parametro regolabile α (inizialmente 0.8) per le coppie GU in una matrice di posizioni a coppie contro tutte, sostituendo il termine di bias nel primo strato del trasformatore. L'addestramento preliminare ha utilizzato il masked language modeling con il 15% dei token sostituiti casualmente, addestrato per 20 giorni su 24 GPU 32G-V100 utilizzando fairseq con un tasso di apprendimento di base di 0.0001, 20.000 passi di riscaldamento e 0.01 di decadimento del peso, generando sia mappe di attenzione (L×L×156) che embedding di token (12×768×L) come output.

• Le mappe di attenzione di ERNIE-RNA hanno dimostrato la capacità di previsione della struttura secondaria dell'RNA zero-shot con un punteggio F1 mediano di 0.552 sul set di test bpRNA-1m, superando RNAfold (0.492), RNAstructure (0.491), RNAErnie (0.440) e RNA-BERT (0.365) senza fine-tuning. Dopo il fine-tuning, ERNIE-RNA ha raggiunto punteggi F1 macro-medi di stato dell'arte di 0.873 su bpRNA-1m, superando RiNALMo (0.850, 650M parametri) e UNI-RNA (0.821, 400M parametri), con una leadership simile su ArchiveII (0.954 contro 0.892 di RiNALMo) e RIVAS TestSetB (0.721 contro 0.555 di RiNALMo). Nei test di generalizzazione inter-famiglia difficili, ERNIE-RNA congelato ha raggiunto punteggi F1 di 0.646 su bpRNA-new e 0.590 su RNA3DB-2D, superando metodi tradizionali di programmazione dinamica come Eternafold (0.639) e mantenendo la superiorità su tutti i concorrenti di deep learning. ERNIE-RNA ha anche ottenuto prestazioni superiori in vari compiti downstream: previsione della mappa di contatto RNA con precisione Top-L/1 di 0.68 (contro l'ensemble di RNAcontact a 0.46), previsione MRL 5'UTR con R² di 0.92 su un set di test casuale e 0.86 su un set di test umano, previsione del legame RNA-proteina superando tutti i metodi testati, accuratezze di classificazione delle famiglie di ncRNA di 0.9844 (0% di rumore al confine) e 0.9820 (200% di rumore al confine), punteggi F1 per la previsione dei siti di splicing che variano da 0.9180 a 0.9612 su quattro specie, accuratezza top-K del 55.37% sul dataset SpliceAI (contro il 34.84% di RNA-FM) e previsione della poliadenilazione alternativa R² del 78.39% (contro il 70.32% di RNA-FM).

Autori: Weijie Yin, Zhaoyu Zhang, Shuo Zhang, Liang He et. al Xuegong Zhang, Tao Qin & Zhen Xie

Link:

634

L'intelligenza artificiale può progettare peptidi terapeutici imitandone il modo in cui le proteine naturali si legano ai bersagli delle malattie?@Tsinghua_Uni @natBME

"Progettazione di peptidi attraverso l'imitazione dell'interfaccia di legame con PepMimic"

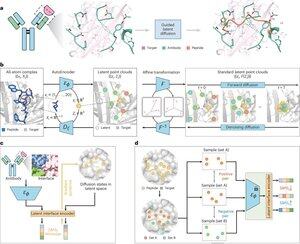

• I ricercatori hanno sviluppato PepMimic, un algoritmo AI che combina un autoencoder a tutti gli atomi, un modello di diffusione latente e un codificatore di interfaccia per progettare peptidi (4-25 aminoacidi) che imitano le interfacce di legame tra proteine bersaglio e leganti noti come anticorpi o recettori, affrontando le limitazioni nella progettazione attuale dei peptidi che richiede competenze manuali e fatica con superfici di legame discontinue.

• Oltre 80 terapie peptidiche sono approvate per malattie tra cui diabete e cancro, offrendo vantaggi come alta specificità, minore tossicità e potenziale somministrazione orale rispetto a piccole molecole e biologici, tuttavia la progettazione di mimetici peptidici delle interazioni proteina-proteina richiede tradizionalmente un'ampia esperienza e non può gestire efficacemente le interfacce di legame discontinue, mentre i modelli AI esistenti si concentrano su approcci backbone-then-sequence piuttosto che catturare la geometria cruciale dei side-chain per interazioni accurate degli aminoacidi.

• PepMimic è stato addestrato su 4.157 complessi proteina-peptide e 70.645 frammenti simili a peptidi dal Protein Data Bank, utilizzando un autoencoder per mappare le geometrie a tutti gli atomi nello spazio latente, un modello di diffusione per 100 passaggi di denoising e apprendimento contrastivo per addestrare un codificatore di interfaccia che guida la generazione minimizzando le distanze tra le interfacce progettate e quelle di riferimento nello spazio latente, con i candidati classificati utilizzando l'energia dell'interfaccia di Rosetta, l'energia di FoldX, metriche di hit dell'interfaccia e punteggi pLDDT di AlphaFold Multimer prima di selezionare i migliori peptidi (384 per bersagli con leganti noti, 94-290 per leganti generati da AI) per esperimenti di imaging a risonanza plasmonica superficiale.

• PepMimic ha raggiunto una media di AUROC di 0,71 su 31 compiti su 93 complessi di test (superando il 0,69 di RFDiffusion), ha progettato 384 peptidi per 5 bersagli farmacologici (PD-L1, CD38, BCMA, HER2, CD4) con l'8% che ha raggiunto KD < 100 nM e 26 peptidi che hanno raggiunto KD a livello di 10⁻⁹ M (notevolmente superiore allo screening casuale della libreria), ha generato peptidi che imitano i leganti progettati da AI per CD38 e TROP2 con un tasso di successo del 14% (16% per CD38, 8% per TROP2), e ha dimostrato un targeting tumorale in vivo efficace in modelli murini con peptidi selezionati che mostrano un'assimilazione 8,85 volte maggiore nei tumori positivi per PD-L1 e 16,18 volte maggiore nei tumori positivi per TROP2, raggiungendo tassi di successo 20.000-90.000 volte superiori rispetto allo screening casuale della libreria sperimentale.

Autori: Xiangzhe Kong et. al Zihua Wang, Yang Liu & @musicsuperman

Link:

1,24K

Principali

Ranking

Preferiti