Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DailyHealthcareAI

Compartir trabajos de investigación y noticias sobre aplicaciones de IA en radiología, patología, genética, diseño de proteínas y muchos más. ¡Aprendamos juntos!

🚀David Baker preprint de @UWproteindesign 👇👇

¿Qué hace que romper enlaces de proteínas sea tan desafiante que la naturaleza evolucionó enzimas especializadas con cofactores metálicos para lograrlo?@biorxivpreprint @ETH_en

"Diseño computacional de cisteína proteasas"

• Los enlaces amida en las proteínas tienen vidas medias de cientos de años en condiciones fisiológicas, lo que los hace mucho más estables que los enlaces éster (con grupos salientes de amina que tienen pKa >35 frente a <8 para ésteres activados), y el diseño computacional previo de enzimas solo ha tenido éxito con sustratos de éster de pequeñas moléculas activadas en lugar de la ruptura de enlaces peptídicos energéticamente exigente requerida para las proteasas.

• Los investigadores utilizaron RoseTTAFold Diffusion 2 para Interfaces Moleculares (RFD2-MI) para diseñar proteasas de zinc a partir de motivos catalíticos mínimos, construyendo un sitio activo ideal con cinco grupos funcionales (tres residuos de unión al zinc H1, H2, E1, una base catalítica E2 y una tirosina estabilizadora de oxianiones Y) basados en las estructuras de aminopeptidasa N y astacina, realizando un diseño bidireccional de las secuencias de proteasa y sustrato para asegurar la posición precisa del enlace amida objetivo.

• De 135 diseños probados en una única ronda de diseño, el 36% mostró actividad (14.7% para modelos solo de Zn y 87.5% para modelos de Zn-agua), con todos los diseños activos rompiendo precisamente en los sitios previstos confirmados por espectrometría de masas; el diseño más activo (Zn45 rompiendo el sustrato ZnO36) logró un kcat de 0.025 ± 0.002 s⁻¹, KM de 26 ± 5 μM, y kcat/KM de 900 ± 200 M⁻¹s⁻¹, representando una aceleración de tasa de >10⁸ veces sobre la hidrólisis no catalizada; los diseños exhibieron unión al zinc con Kd entre 10⁻¹⁰ y 10⁻⁸ M, mostraron especificidad de sustrato en 4 de 5 andamios, y podrían ser reprogramados para romper la proteína humana TDP-43 relevante para enfermedades con 4 variantes logrando ≥80% de ruptura a las 5 horas.

Autores: Hojae Choi et. al Donald Hilvert, Samuel J. Pellock, David Baker

Enlace:

696

¿Puede un modelo de lenguaje aprender la estructura del ARN sin datos de entrenamiento estructurales explícitos?@NatureComms @Tsinghua_Uni

"ERNIE-RNA: un modelo de lenguaje de ARN con representaciones mejoradas por la estructura"

• Los modelos de lenguaje de ARN existentes pasan por alto la información estructural en las secuencias, lo que lleva a una extracción de características incompleta y un rendimiento subóptimo, a pesar de la organización jerárquica del ARN donde las secuencias primarias se pliegan en conformaciones estructurales específicas que determinan funciones biológicas. Los enfoques computacionales tradicionales para la predicción de estructuras de ARN enfrentan desafíos distintos: los métodos basados en termodinámica están limitados por la precisión de los parámetros, los métodos basados en alineamientos luchan sin suficientes secuencias homólogas, y los modelos de aprendizaje profundo muestran una generalización limitada a familias de ARN no vistas. Si bien han surgido modelos de lenguaje de ARN al estilo BERT como RNA-FM (entrenado en 23 millones de secuencias), UNI-RNA (1 mil millones de secuencias, 400M parámetros) y RiNALMo (36M secuencias, 650M parámetros), no logran incorporar adecuadamente la información estructural, con algunos como UTR-LM intentando abordar esto al incorporar estructuras predichas de RNAfold, pero enfrentando limitaciones debido a errores de predicción y una capacidad de generalización reducida.

• ERNIE-RNA es un modelo de lenguaje de ARN preentrenado de 86 millones de parámetros basado en una arquitectura BERT modificada con 12 bloques de transformadores y 12 cabezales de atención, entrenado en 20.4 millones de secuencias de ARN no codificante de RNAcentral después de filtrar secuencias más largas de 1022 nucleótidos y aplicar eliminación de redundancia CD-HIT con 100% de similitud. El modelo incorpora un mecanismo de sesgo de atención informado por emparejamiento de bases que asigna valores de 2 para pares AU, 3 para pares CG, y un parámetro ajustable α (inicialmente 0.8) para pares GU en una matriz de posición par a par, reemplazando el término de sesgo en la primera capa de transformador. El preentrenamiento utilizó modelado de lenguaje enmascarado con el 15% de los tokens reemplazados aleatoriamente, entrenado durante 20 días en 24 GPUs 32G-V100 usando fairseq con una tasa de aprendizaje base de 0.0001, 20,000 pasos de calentamiento y 0.01 de decaimiento de peso, generando tanto mapas de atención (L×L×156) como incrustaciones de tokens (12×768×L) como salidas.

• Los mapas de atención de ERNIE-RNA demostraron capacidad de predicción de estructura secundaria de ARN en cero disparos con una puntuación F1 mediana de 0.552 en el conjunto de prueba bpRNA-1m, superando a RNAfold (0.492), RNAstructure (0.491), RNAErnie (0.440) y RNA-BERT (0.365) sin ajuste fino. Después del ajuste fino, ERNIE-RNA logró puntuaciones F1 promedio macro de vanguardia de 0.873 en bpRNA-1m, superando a RiNALMo (0.850, 650M parámetros) y UNI-RNA (0.821, 400M parámetros), con un liderazgo similar en ArchiveII (0.954 frente a 0.892 de RiNALMo) y RIVAS TestSetB (0.721 frente a 0.555 de RiNALMo). En desafiantes pruebas de generalización entre familias, ERNIE-RNA congelado logró puntuaciones F1 de 0.646 en bpRNA-new y 0.590 en RNA3DB-2D, superando a métodos tradicionales de programación dinámica como Eternafold (0.639) y manteniendo la superioridad sobre todos los competidores de aprendizaje profundo. ERNIE-RNA también logró un rendimiento superior en diversas tareas posteriores: predicción de mapas de contacto de ARN con precisión Top-L/1 de 0.68 (frente a 0.46 del conjunto de RNAcontact), predicción de MRL de 5'UTR con R² de 0.92 en el conjunto de prueba aleatorio y 0.86 en el conjunto de prueba humano, predicción de unión ARN-proteína superando todos los métodos probados, precisiones de clasificación de familias de ncRNA de 0.9844 (0% de ruido en los límites) y 0.9820 (200% de ruido en los límites), puntuaciones F1 de predicción de sitios de empalme que varían de 0.9180 a 0.9612 en cuatro especies, precisión top-K del 55.37% en el conjunto de datos SpliceAI (frente al 34.84% de RNA-FM), y predicción de poliadenilación alternativa con R² de 78.39% (frente al 70.32% de RNA-FM).

Autores: Weijie Yin, Zhaoyu Zhang, Shuo Zhang, Liang He et. al Xuegong Zhang, Tao Qin & Zhen Xie

Enlace:

715

¿Puede la inteligencia artificial diseñar péptidos terapéuticos imitando cómo las proteínas naturales se unen a los objetivos de enfermedades?@Tsinghua_Uni @natBME

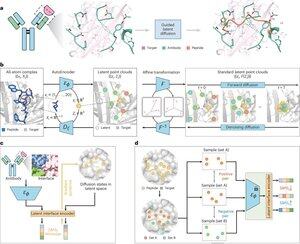

"Diseño de péptidos a través de la imitación de interfaces de unión con PepMimic"

• Los investigadores desarrollaron PepMimic, un algoritmo de IA que combina un autoencoder de átomos completos, un modelo de difusión latente y un codificador de interfaz para diseñar péptidos (4-25 aminoácidos) que imitan las interfaces de unión entre proteínas objetivo y uniones conocidas como anticuerpos o receptores, abordando las limitaciones en el diseño actual de péptidos que requiere experiencia manual y lucha con superficies de unión discontinuas.

• Más de 80 terapias péptidas están aprobadas para enfermedades como la diabetes y el cáncer, ofreciendo ventajas como alta especificidad, menor toxicidad y potencial administración oral en comparación con pequeñas moléculas y biológicos, sin embargo, el diseño de miméticos péptidos de interacciones proteína-proteína tradicionalmente requiere una amplia experiencia y no puede manejar eficazmente interfaces de unión discontinuas, mientras que los modelos de IA existentes se centran en enfoques de columna vertebral y luego secuencia en lugar de capturar la geometría crucial de la cadena lateral para interacciones precisas de aminoácidos.

• PepMimic fue entrenado en 4,157 complejos proteína-péptido y 70,645 fragmentos similares a péptidos del Protein Data Bank, utilizando un autoencoder para mapear geometrías de átomos completos a un espacio latente, un modelo de difusión para 100 pasos de eliminación de ruido, y aprendizaje contrastivo para entrenar un codificador de interfaz que guía la generación minimizando las distancias entre las interfaces diseñadas y de referencia en el espacio latente, con candidatos clasificados utilizando energía de interfaz de Rosetta, energía de FoldX, métricas de impacto de interfaz y puntajes pLDDT de AlphaFold Multimer antes de seleccionar los mejores péptidos (384 para objetivos con uniones conocidas, 94-290 para uniones generadas por IA) para experimentos de imagen de resonancia de plasmones superficiales.

• PepMimic logró una AUROC media de 0.71 en 31 tareas en 93 complejos de prueba (superando el 0.69 de RFDiffusion), diseñó 384 péptidos para 5 objetivos de fármacos (PD-L1, CD38, BCMA, HER2, CD4) con un 8% logrando KD < 100 nM y 26 péptidos alcanzando KD en el nivel de 10⁻⁹ M (sustancialmente más alto que la selección aleatoria de bibliotecas), generó péptidos que imitan uniones diseñadas por IA para CD38 y TROP2 con una tasa de éxito del 14% (16% para CD38, 8% para TROP2), y demostró una efectiva orientación tumoral in vivo en modelos de ratón con péptidos seleccionados mostrando una captación 8.85 veces mayor en tumores positivos para PD-L1 y 16.18 veces mayor en tumores positivos para TROP2, logrando tasas de éxito 20,000-90,000 veces más altas que la selección aleatoria experimental de bibliotecas.

Autores: Xiangzhe Kong et. al Zihua Wang, Yang Liu & @musicsuperman

Enlace:

1,3K

Parte superior

Clasificación

Favoritos