Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DailyHealthcareAI

Partilhar artigos de investigação e notícias sobre aplicações de IA em radiologia, patologia, genética, design de proteínas e muito mais. Vamos aprender juntos!

🚀David Baker preprint de @UWproteindesign 👇👇

O que torna tão desafiador cortar ligações de proteínas que a natureza evoluiu enzimas especializadas com cofatores metálicos para realizá-lo?@biorxivpreprint @ETH_en

"Design computacional de cisteína proteases"

• As ligações amida em proteínas têm meias-vidas de centenas de anos em condições fisiológicas, tornando-as muito mais estáveis do que as ligações éster (com grupos de saída de amina tendo pKa >35 versus <8 para ésteres ativados), e o design computacional de enzimas anterior só teve sucesso com substratos de éster de pequenas moléculas ativadas, em vez da clivagem de ligações peptídicas energeticamente exigente necessária para proteases.

• Os pesquisadores usaram RoseTTAFold Diffusion 2 para Interfaces Moleculares (RFD2-MI) para projetar proteases de zinco a partir de motivos catalíticos mínimos, construindo um sítio ativo ideal com cinco grupos funcionais (três resíduos de ligação de zinco H1, H2, E1, uma base catalítica E2 e uma tirosina Y estabilizadora de oxiânion) com base nas estruturas de aminopeptidase N e astacina, realizando um design bidirecional tanto das sequências de protease quanto de substrato para garantir o posicionamento preciso da ligação amida alvo.

• De 135 designs testados em uma única rodada de design, 36% mostraram atividade (14,7% para modelos apenas de Zn e 87,5% para modelos de Zn-água), com todos os designs ativos clivando precisamente nos locais pretendidos confirmados por espectrometria de massa; o design mais ativo (Zn45 clivando o substrato ZnO36) alcançou kcat de 0,025 ± 0,002 s⁻¹, KM de 26 ± 5 μM, e kcat/KM de 900 ± 200 M⁻¹s⁻¹, representando uma aceleração de taxa >10⁸ vezes em relação à hidrólise não catalisada; os designs exibiram ligação de zinco com Kd entre 10⁻¹⁰ e 10⁻⁸ M, mostraram especificidade de substrato em 4 de 5 andaimes, e poderiam ser reprogramados para clivar a proteína humana TDP-43 relevante para doenças, com 4 variantes alcançando ≥80% de clivagem em 5 horas.

Autores: Hojae Choi et. al Donald Hilvert, Samuel J. Pellock, David Baker

Link:

611

Um modelo de linguagem pode aprender a estrutura do RNA sem dados de treinamento estrutural explícitos?@NatureComms @Tsinghua_Uni

"ERNIE-RNA: um modelo de linguagem RNA com representações melhoradas por estrutura"

• Os modelos de linguagem RNA existentes ignoram informações estruturais nas sequências, levando a uma extração de características incompleta e desempenho subótimo, apesar da organização hierárquica do RNA, onde sequências primárias se dobram em conformações estruturais específicas que determinam funções biológicas. Abordagens computacionais tradicionais para previsão de estrutura de RNA enfrentam desafios distintos: métodos baseados em termodinâmica são limitados pela precisão dos parâmetros, métodos baseados em alinhamento lutam sem sequências homólogas suficientes, e modelos de aprendizado profundo mostram generalização limitada para famílias de RNA não vistas. Embora modelos de linguagem RNA estilo BERT como RNA-FM (treinado em 23 milhões de sequências), UNI-RNA (1 bilhão de sequências, 400M parâmetros) e RiNALMo (36M sequências, 650M parâmetros) tenham surgido, eles falham em incorporar adequadamente informações estruturais, com alguns como UTR-LM tentando abordar isso ao incorporar estruturas previstas do RNAfold, mas enfrentando limitações devido a erros de previsão e capacidade de generalização reduzida.

• ERNIE-RNA é um modelo de linguagem RNA pré-treinado com 86 milhões de parâmetros baseado em uma arquitetura BERT modificada com 12 blocos de transformadores e 12 cabeças de atenção, treinado em 20,4 milhões de sequências de RNA não codificante do RNAcentral após filtrar sequências mais longas que 1022 nucleotídeos e aplicar a remoção de redundância CD-HIT a 100% de similaridade. O modelo incorpora um mecanismo de viés de atenção informado por emparelhamento de bases que atribui valores de 2 para pares AU, 3 para pares CG, e um parâmetro ajustável α (inicialmente 0.8) para pares GU em uma matriz de posição par-a-par, substituindo o termo de viés na primeira camada de transformador. O pré-treinamento utilizou modelagem de linguagem mascarada com 15% dos tokens substituídos aleatoriamente, treinado por 20 dias em 24 GPUs 32G-V100 usando fairseq com taxa de aprendizado base de 0.0001, 20.000 passos de aquecimento e 0.01 de decaimento de peso, gerando tanto mapas de atenção (L×L×156) quanto embeddings de tokens (12×768×L) como saídas.

• Os mapas de atenção do ERNIE-RNA demonstraram capacidade de previsão de estrutura secundária de RNA zero-shot com uma pontuação F1 mediana de 0.552 no conjunto de teste bpRNA-1m, superando RNAfold (0.492), RNAstructure (0.491), RNAErnie (0.440) e RNA-BERT (0.365) sem ajuste fino. Após o ajuste fino, o ERNIE-RNA alcançou pontuações F1 macro-média de estado da arte de 0.873 no bpRNA-1m, superando RiNALMo (0.850, 650M parâmetros) e UNI-RNA (0.821, 400M parâmetros), com liderança semelhante no ArchiveII (0.954 vs 0.892 do RiNALMo) e no RIVAS TestSetB (0.721 vs 0.555 do RiNALMo). Em testes desafiadores de generalização entre famílias, o ERNIE-RNA congelado alcançou pontuações F1 de 0.646 no bpRNA-new e 0.590 no RNA3DB-2D, superando métodos tradicionais de programação dinâmica como Eternafold (0.639) e mantendo superioridade sobre todos os concorrentes de aprendizado profundo. O ERNIE-RNA também alcançou desempenho superior em diversas tarefas subsequentes: previsão de mapa de contato de RNA com precisão Top-L/1 de 0.68 (vs 0.46 do ensemble RNAcontact), previsão de MRL de 5'UTR com R² de 0.92 no conjunto de teste aleatório e 0.86 no conjunto de teste humano, previsão de ligação RNA-proteína superando todos os métodos testados, precisões de classificação de família ncRNA de 0.9844 (0% de ruído de limite) e 0.9820 (200% de ruído de limite), pontuações F1 de previsão de sítio de splicing variando de 0.9180 a 0.9612 em quatro espécies, precisão top-K de 55.37% no conjunto de dados SpliceAI (vs 34.84% do RNA-FM), e previsão de poliadenilação alternativa com R² de 78.39% (vs 70.32% do RNA-FM).

Autores: Weijie Yin, Zhaoyu Zhang, Shuo Zhang, Liang He et. al Xuegong Zhang, Tao Qin & Zhen Xie

Link:

636

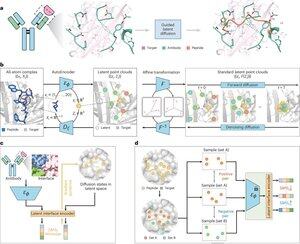

A inteligência artificial pode projetar peptídeos terapêuticos imitando como proteínas naturais se ligam a alvos de doenças?@Tsinghua_Uni @natBME

"Projeto de peptídeos através da imitação da interface de ligação com PepMimic"

• Pesquisadores desenvolveram o PepMimic, um algoritmo de IA que combina um autoencoder de todos os átomos, um modelo de difusão latente e um codificador de interface para projetar peptídeos (4-25 aminoácidos) que imitam interfaces de ligação entre proteínas-alvo e ligantes conhecidos como anticorpos ou receptores, abordando limitações no design atual de peptídeos que requer expertise manual e enfrenta dificuldades com superfícies de ligação descontínuas.

• Mais de 80 terapias peptídicas estão aprovadas para doenças, incluindo diabetes e câncer, oferecendo vantagens como alta especificidade, menor toxicidade e potencial administração oral em comparação com pequenas moléculas e biológicos, no entanto, projetar imitações peptídicas de interações proteína-proteína tradicionalmente requer extensa expertise e não consegue lidar efetivamente com interfaces de ligação descontínuas, enquanto modelos de IA existentes se concentram em abordagens de backbone-then-sequence em vez de capturar a geometria crucial da cadeia lateral para interações precisas de aminoácidos.

• O PepMimic foi treinado em 4.157 complexos proteína-peptídeo e 70.645 fragmentos semelhantes a peptídeos do Banco de Dados de Proteínas, usando um autoencoder para mapear geometrias de todos os átomos para o espaço latente, um modelo de difusão para 100 etapas de desnoising, e aprendizado contrastivo para treinar um codificador de interface que orienta a geração minimizando distâncias entre interfaces projetadas e de referência no espaço latente, com candidatos classificados usando energia de interface Rosetta, energia FoldX, métricas de acerto de interface e pontuações pLDDT do AlphaFold Multimer antes de selecionar os principais peptídeos (384 para alvos com ligantes conhecidos, 94-290 para ligantes gerados por IA) para experimentos de imagem de ressonância de plasmon de superfície.

• O PepMimic alcançou uma média de AUROC de 0,71 em 31 tarefas em 93 complexos de teste (superando o 0,69 do RFDiffusion), projetou 384 peptídeos para 5 alvos de medicamentos (PD-L1, CD38, BCMA, HER2, CD4) com 8% alcançando KD < 100 nM e 26 peptídeos atingindo KD no nível de 10⁻⁹ M (substantivamente mais alto do que a triagem de biblioteca aleatória), gerou peptídeos imitando ligantes projetados por IA para CD38 e TROP2 com taxa de sucesso de 14% (16% para CD38, 8% para TROP2), e demonstrou efetividade em direcionamento tumoral in vivo em modelos de camundongos com peptídeos selecionados mostrando 8,85 vezes maior captação em tumores positivos para PD-L1 e 16,18 vezes maior captação em tumores positivos para TROP2, alcançando taxas de sucesso 20.000-90.000 vezes superiores à triagem experimental de biblioteca aleatória.

Autores: Xiangzhe Kong et. al Zihua Wang, Yang Liu & @musicsuperman

Link:

1,25K

Top

Classificação

Favoritos